O guia definitivo para modelos populares de idiomas grandes

Imagine que você está se esforçando para escrever a história perfeita, com os dedos pairando sobre o teclado enquanto a página em branco o provoca. De repente, você se lembra de sua arma secreta: um modelo de linguagem grande (LLM). Com algumas instruções, o LLM tece uma história tão cativante que parece mágica. Esse é apenas um exemplo do poder dos LLMs, sofisticados sistemas de IA que estão remodelando a maneira como interagimos com a tecnologia.

No mundo intrigante e em constante mudança da Inteligência Artificial (IA), os modelos de linguagem de grande porte (LLMs) estão causando impacto com suas impressionantes capacidades de lidar com a linguagem humana. Mas o que são exatamente esses LLMs e como eles revolucionam nossas interações e tarefas diárias? Vamos nos aprofundar nessa área cativante e descobrir alguns dos LLMs mais proeminentes que estão moldando o futuro da IA.

Compreensão de grandes modelos de linguagem

Os LLMs são modelos avançados de aprendizado de máquina que preveem e geram textos semelhantes aos humanos. Eles podem autocompletar frases, traduzir idiomas e até mesmo criar artigos inteiros. Esses modelos evoluíram de simples preditores de palavras para sistemas complexos capazes de lidar com parágrafos e documentos.

Como funcionam os modelos de idiomas grandes?

Os LLMs estimam a probabilidade de sequências de palavras, usando vastos conjuntos de dados para aprender padrões de linguagem. Eles são desenvolvidos em arquiteturas como Transformers, que se concentram nas partes mais relevantes da entrada para processar sequências mais longas com eficiência.

A evolução dos LLMs: Do BERT ao GPT-4

Exemplos de modelos de linguagem grandes em ação

ChatGPTA OpenAI, uma variante dos modelos GPT da OpenAI, tornou-se um nome conhecido, alimentando chatbots que oferecem interações semelhantes às humanas.

Impacto do BERT nas tarefas de processamento de linguagem natural

O BERT melhorou significativamente o desempenho das tarefas de processamento de linguagem natural, como a análise de sentimentos e a tradução de idiomas.

GPT-3 e a fronteira da geração de texto

A capacidade do GPT-3 de gerar textos criativos e coerentes abriu novas possibilidades na criação de conteúdo e muito mais.

Uma folha de referência para a comparação dos principais modelos de idiomas grandes da atualidade

Para entender melhor a magnitude e a diversidade dos modelos de linguagem de grande porte, vamos dar uma olhada mais de perto em alguns dos modelos mais influentes disponíveis publicamente e que dominam o cenário atualmente. Cada modelo traz pontos fortes exclusivos e se destaca em vários casos de uso.

Esta tabela fornece uma visão geral rápida de alguns dos modelos de linguagem grandes mais influentes em 2024. O BERT, lançado pelo Google, é conhecido por sua arquitetura baseada em transformadores e foi um avanço significativo nas tarefas de processamento de linguagem natural. Cláudiodesenvolvido pela Anthropic, concentra-se na IA constitucional, com o objetivo de tornar os resultados da IA úteis, inofensivos e precisos. CoesãoO Ernie, um LLM empresarial, oferece treinamento personalizado e ajuste fino para casos de uso específicos da empresa. O Ernie, do Baidu, tem impressionantes 10 trilhões de parâmetros e foi projetado para se destacar em mandarim, mas também é capaz de falar outros idiomas.

LLMs locais vs. LLMs na nuvem

Embora os LLMs baseados em nuvem ofereçam recursos impressionantes, uma tendência crescente é o uso de inferência local com modelos de código aberto. Ferramentas como o LM Studio permitem que os usuários executem executar LLMs localmente diretamente em suas máquinas.

Essa abordagem prioriza a privacidade, mantendo todos os dados e o processamento off-line. No entanto, a inferência local normalmente requer hardware mais potente e pode limitar o acesso aos modelos mais avançados devido ao seu tamanho.

Os 15 modelos mais populares de idiomas grandes

| Nome do modelo | Tamanho (parâmetros) | Código aberto? | Última atualização (estimada) | Empresa | País de desenvolvimento |

| AI21 Studios Jurassic-1 Jumbo | 178B | Sim | Dezembro de 2022 | AI21 Studios | Israel |

| Google Gemma | 2B ou 7B | Sim | Maio de 2023 | IA do Google | Estados Unidos |

| Meta LLaMA 13B | 13B | Sim | Início de 2023 | Meta AI | Estados Unidos |

| Meta LLaMA 7B | 7B | Sim | Início de 2023 | Meta AI | Estados Unidos |

| EleutherAI GPT-J | 6B | Sim | Maio de 2023 (por meio de bifurcações como Dolly 2) | EleutherAI (grupo de pesquisa) | Estados Unidos |

| A pilha - EleutherAI | 900 GB de dados de texto | Sim | Desenvolvimento contínuo | EleutherAI (grupo de pesquisa) | Estados Unidos |

| Mistral AI - Mistral Grande | Não divulgado publicamente (Grande) | Código aberto com opções pagas | Setembro de 2023 | Mistral AI | França |

| Falcon 180B | 180B | Sim | Não especificado | Instituto de Inovação Tecnológica | EMIRADOS ÁRABES UNIDOS |

| BERT | 342 milhões | Não | Julho de 2018 | IA do Google | Estados Unidos |

| Ernie | 10 trilhões | Não | Agosto de 2023 | Baidu | China |

| OpenAI GPT-3.5 | 175B | Não | Final de 2022 | OpenAI | Estados Unidos |

| Cláudio | Não especificado | Não | Não especificado | Antrópica | Estados Unidos |

| Coesão | Não divulgado publicamente (maciço) | Não | Desenvolvimento contínuo | Coesão | Canadá |

| Google PaLM (foco de pesquisa) | Não divulgado publicamente (provavelmente muito grande) | Não | Em desenvolvimento | IA do Google | Estados Unidos |

| OpenAI GPT-4 | Não divulgado publicamente (sucessor do GPT-3.5) | Não | Em desenvolvimento | OpenAI | Estados Unidos |

Comparação entre países de desenvolvimento de LLMs

Ao comparar os 15 principais modelos de linguagem grande (LLMs), os Estados Unidos contribuem com quase 67% da participação no mercado de desenvolvimento de LLMs em 10 dos 15.

| País de desenvolvimento | Número de modelos |

| Canadá | 1 |

| China | 1 |

| França | 1 |

| Israel | 1 |

| EMIRADOS ÁRABES UNIDOS | 1 |

| Estados Unidos | 10 |

| Total geral | 15 |

Arquiteturas de LLM e métodos de treinamento

| Arquitetura/Método | Descrição |

|---|---|

| Transformador | Uma arquitetura de rede neural que se baseia em mecanismos de atenção para melhorar a eficiência e a precisão do processamento de dados sequenciais. É a base de muitos LLMs modernos. |

| Pré-treinamento | O estágio inicial do treinamento de um LLM, expondo-o a uma grande quantidade de dados de texto não rotulados para aprender os padrões e as estruturas estatísticas do idioma. |

| Ajuste fino | Refinamento de um modelo pré-treinado, treinando-o em dados específicos relacionados a uma determinada tarefa, melhorando seu desempenho para essa tarefa. |

| QLoRA | Um método que envolve gradientes de retropropagação por meio de um modelo de linguagem pré-treinado, congelado e quantizado de 4 bits em Low Rank Adapters (LoRA), permitindo um ajuste fino eficiente. |

A arquitetura do transformador revolucionou o campo do processamento de linguagem natural, permitindo que os modelos lidem com longas sequências de dados de forma mais eficaz. O pré-treinamento e o ajuste fino são estágios essenciais no desenvolvimento dos LLMs, permitindo que eles aprendam com grandes quantidades de dados e, em seguida, se especializem em tarefas específicas. O QLoRA representa uma técnica avançada para o ajuste fino dos LLMs, reduzindo as demandas de memória e mantendo o desempenho

Principais casos de uso de modelos de idiomas grandes

Como os LLMs revolucionam a tradução de idiomas e a análise de sentimentos

Os LLMs transformaram a tradução de idiomas ao compreender e traduzir grandes quantidades de dados, enquanto a análise de sentimentos se tornou mais matizada graças aos seus recursos de aprendizagem profunda.

Aprimorando as interações homem-máquina com chatbots

Os chatbots com tecnologia de LLMs oferecem suporte personalizado e eficiente ao cliente, mudando a cara do atendimento ao cliente.

Transformando a criação de conteúdo por meio da IA generativa

Os modelos de IA generativa, como o GPT-3, possibilitaram a criação rápida de conteúdo de alta qualidade, auxiliando tanto escritores quanto designers.

Desafios e limitações da implementação de LLMs

Abordagem de preocupações sobre preconceito e uso ético

Os dados de treinamento para LLMs podem introduzir vieses, levantando questões éticas que devem ser abordadas.

Entendendo os custos computacionais do treinamento de modelos grandes

O treinamento de LLMs requer recursos computacionais significativos, que podem ser caros e insustentáveis do ponto de vista ambiental.

As limitações na compreensão da linguagem e no entendimento do contexto

Apesar de seus recursos, os LLMs ainda têm dificuldades para entender o contexto e as sutilezas da linguagem humana.

Como os modelos de linguagem grandes são treinados e ajustados

A importância de grandes quantidades de dados no pré-treinamento de LLMs

Os LLMs exigem grandes conjuntos de dados para aprender uma ampla gama de padrões e nuances de linguagem.

Técnicas de ajuste fino para aplicações específicas

Técnicas como aprendizagem por transferência e ajuste fino com modelos de transformadores são usadas para adaptar os LLMs a tarefas específicas.

Surgimento de modelos básicos no aprendizado de máquina

Os modelos básicos são uma nova tendência no aprendizado de máquina, fornecendo uma base para a criação de modelos especializados.

Diferenças entre o pré-treinamento e o treinamento específico da tarefa

O pré-treinamento e o treinamento específico da tarefa (geralmente chamado de ajuste fino) são duas fases críticas no desenvolvimento de modelos de linguagem grandes (LLMs). Esses estágios são fundamentais para a forma como os LLMs entendem e geram textos semelhantes aos humanos, cada um servindo a um propósito distinto no processo de aprendizado do modelo.

LLMs de pré-treinamento

O pré-treinamento é a fase inicial e extensa em que um LLM aprende com um vasto corpus de dados de texto. Esse estágio é semelhante a dar ao modelo uma ampla educação sobre idioma, cultura e conhecimento geral. Aqui estão os principais aspectos do pré-treinamento:

- Base de conhecimento geral: O modelo desenvolve uma compreensão de gramática, expressões idiomáticas, fatos e contexto por meio da análise de um grande corpus de texto. Essa ampla base de conhecimento permite que o modelo gere respostas coerentes e contextualmente apropriadas.

- Aprendizagem por transferência: Os modelos pré-treinados podem aplicar seus padrões de linguagem aprendidos a novos conjuntos de dados, o que é especialmente útil para tarefas com dados limitados. Essa capacidade reduz significativamente a necessidade de dados extensos específicos da tarefa.

- Custo-efetividade: Apesar dos recursos computacionais substanciais necessários para o pré-treinamento, o mesmo modelo pode ser reutilizado em vários aplicativos, o que o torna uma abordagem econômica.

- Flexibilidade e escalabilidade: A ampla compreensão obtida durante o pré-treinamento permite que o mesmo modelo seja adaptado para diversas tarefas. Além disso, à medida que novos dados se tornam disponíveis, os modelos pré-treinados podem ser treinados ainda mais para melhorar seu desempenho.

Treinamento específico para tarefas (ajuste fino)

Após o pré-treinamento, os modelos passam por um ajuste fino, no qual são treinados em conjuntos de dados menores e específicos de tarefas. Essa fase adapta o amplo conhecimento do modelo para que ele tenha um bom desempenho em tarefas específicas. Os principais aspectos do ajuste fino incluem:

- Especialização em tarefas: O ajuste fino adapta modelos pré-treinados a tarefas ou setores específicos, melhorando seu desempenho em aplicativos específicos.

- Eficiência e velocidade dos dados: Como o modelo já aprendeu padrões gerais de linguagem durante o pré-treinamento, o ajuste fino requer menos dados e tempo para especializar o modelo para tarefas específicas.

- Personalização de modelos: O ajuste fino permite a personalização do modelo para atender aos requisitos exclusivos de diferentes tarefas, tornando-o altamente adaptável a aplicações de nicho.

- Eficiência de recursos: O ajuste fino é particularmente vantajoso para aplicativos com recursos computacionais limitados, pois aproveita o trabalho pesado feito durante o pré-treinamento.

Em resumo, o pré-treinamento equipa os LLMs com uma ampla compreensão da linguagem e do conhecimento geral, enquanto o ajuste fino adapta esse conhecimento para que se sobressaia em tarefas específicas. O pré-treinamento estabelece a base para os recursos de linguagem do modelo e o ajuste fino otimiza esses recursos para aplicativos específicos, equilibrando a generalização e a especialização do modelo.

O futuro dos modelos de idiomas grandes

Antecipando os LLMs de próxima geração: GPT-4 e além

A próxima geração de LLMs, como o GPT-4, deverá ampliar ainda mais os limites do que é possível em IA.

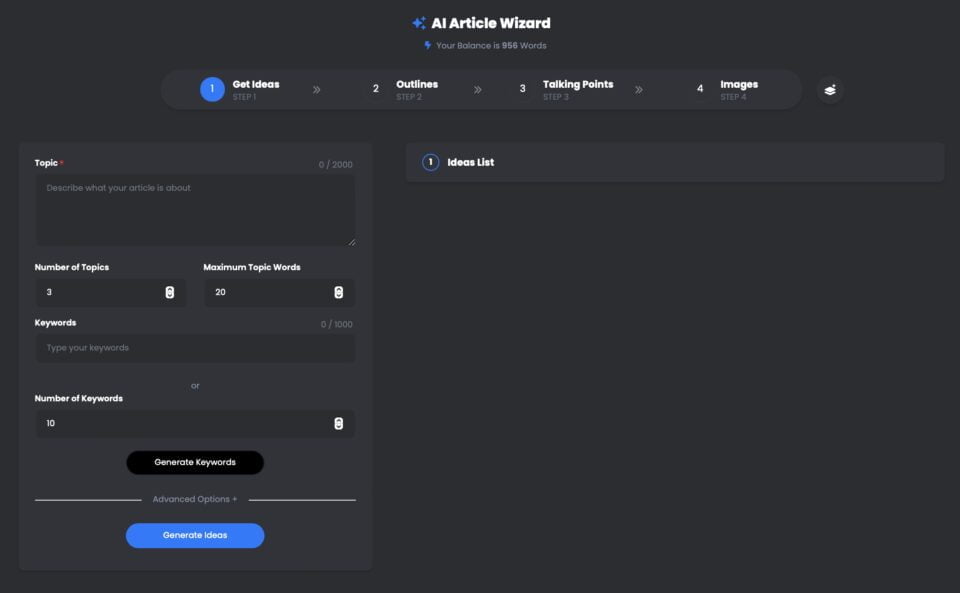

Assistente de artigos de IA do UberCreate é uma ferramenta avançada que utiliza o modelo de linguagem grande (LLM) GPT-4 da OpenAI para gerar artigos de alta qualidade em minutos.

Com o UberCreate, você pode dizer adeus ao bloqueio de escritor e olá para um artigo detalhado em minutos. Você só precisa fornecer um tópico, uma palavra-chave e uma meta de contagem de palavras, e o UberCreate cuidará do resto. Ele gerará um esboço de artigo, pontos de discussão, imagens relevantes e um artigo final pronto para ser publicado.

Assistente de artigo de IA do UberCreate usando GPT-4

Pino

Pino O UberCreate usa tecnologia avançada de inteligência artificial para criar conteúdo original, envolvente e informativo. Ele pode escrever sobre qualquer assunto, desde negócios e marketing até saúde e estilo de vida. Ele também pode se adaptar a diferentes tons, estilos e formatos, dependendo de suas preferências e necessidades.

O UberCreate não é apenas um gerador de conteúdo, mas também um aprimorador de conteúdo. Ele pode ajudá-lo a melhorar seus artigos existentes adicionando mais detalhes, fatos e imagens. Ele também pode verificar a gramática, a ortografia e a legibilidade, além de sugerir maneiras de otimizar seu conteúdo para SEO e mídia social.

O UberCreate é a única ferramenta de criação de conteúdo com IA de que você precisará. Ele combina 17 ferramentas de IA em uma só, incluindo um gerador de posts de blog, um gerador de conteúdo de mídia social, um gerador de conteúdo visual e muito mais. Ele foi projetado para facilitar todos os aspectos da criação de conteúdo, desde a ideação até a produção.

Seja você um blogueiro, um profissional de marketing, um estudante ou um profissional, o UberCreate pode ajudá-lo a economizar tempo, dinheiro e esforço na criação de conteúdo de alta qualidade. Você pode experimentá-lo gratuitamente e ver os resultados por si mesmo.

Expandindo os limites da colaboração entre humanos e IA

LLMs estão definidas para aprimorar a colaboração entre humanos e IA, tornando as interações mais naturais e produtivas.

Esses LLMs de destaque são apenas a ponta do iceberg quando se trata de compreender o vasto potencial dos modelos de linguagem de grande porte para revolucionar nossas interações com a tecnologia e expandir os limites da colaboração entre humanos e IA. Fique atento à Parte II desta série, na qual nos aprofundaremos nos recursos dos modelos de linguagem de grande porte, em suas aplicações em vários setores e nos desafios decorrentes do aproveitamento de seu poder.

Perspectivas da compreensão de linguagem natural na próxima década

O futuro parece promissor para a compreensão de linguagem natural, com os LLMs se tornando mais sofisticados e integrados a vários aplicativos.

Em conclusãoOs LLMs, como o BERT, o GPT-3 e seus sucessores, estão revolucionando os setores, da educação à saúde. À medida que continuamos a aproveitar seu poder, também precisamos enfrentar os desafios que eles apresentam, garantindo seu uso ético e responsável. A jornada no mundo dos grandes modelos de linguagem está apenas começando, e as possibilidades são tão vastas quanto os conjuntos de dados com os quais eles aprendem. Mergulhe nesse campo empolgante e vamos juntos moldar o futuro da IA.

Perguntas frequentes (FAQ)

O que é um modelo de linguagem grande (LLM) no contexto da PNL?

Um Modelo de Linguagem Grande (LLM), no escopo do Processamento de Linguagem Natural (PLN), refere-se a um sistema avançado de IA projetado para entender, interpretar e gerar texto semelhante ao humano. Esses modelos são treinados em grandes quantidades de dados, o que lhes permite executar uma ampla gama de tarefas linguísticas. Por meio do processo de treinamento, o modelo aprende a prever a próxima palavra em uma frase, ajudando-o a gerar textos coerentes e contextualmente relevantes sob demanda.

Quais são os diferentes tipos de LLMs disponíveis em 2024?

A partir de 2024, haverá vários tipos diferentes de modelos de linguagem grandes disponíveis, cada um com recursos exclusivos. Os mais notáveis incluem modelos como o GPT-4, que é conhecido por suas habilidades de geração de texto, e o Bard, que é a contraparte do Google com foco em uma ampla gama de tarefas de PNL. Esses modelos diferem no número de parâmetros, nos dados em que foram treinados e em suas aplicações específicas, que vão desde a geração de texto simples até tarefas complexas de compreensão de linguagem.

Como os LLMs são treinados em grandes conjuntos de dados?

Os LLMs são treinados usando vastos conjuntos de dados coletados da Internet, incluindo livros, artigos e sites. Esse extenso processo de treinamento envolve alimentar o modelo com grandes quantidades de dados de texto, o que ajuda o modelo a identificar padrões, entender o contexto e aprender estruturas de linguagem. O processo de treinamento pode levar semanas ou até meses, dependendo do tamanho do modelo e dos recursos computacionais disponíveis. O objetivo é permitir que o modelo gere texto indistinguível daquele escrito por humanos.

Você pode explicar as aplicações dos LLMs em tarefas cotidianas?

Os LLMs podem ser usados em uma variedade de aplicativos para simplificar e automatizar tarefas cotidianas. Isso inclui chatbots e assistentes virtuais para atendimento ao cliente, ferramentas de criação de conteúdo para gerar artigos ou relatórios e serviços de tradução para converter textos entre idiomas. Outros aplicativos envolvem a análise de sentimentos para avaliar a opinião pública nas mídias sociais, ferramentas de resumo para condensar documentos longos em versões mais curtas e até mesmo assistentes de codificação para ajudar os programadores gerando trechos de código. Essencialmente, os LLMs revolucionaram a forma como interagimos com a tecnologia, tornando-a mais intuitiva e semelhante à humana.

Como os recursos dos modelos de linguagem grandes diferem dos modelos tradicionais?

Os modelos de linguagem grandes superam significativamente os modelos tradicionais de várias maneiras. Em primeiro lugar, devido ao seu treinamento extensivo em diversos conjuntos de dados, os LLMs podem gerar respostas mais coerentes, variadas e contextualmente apropriadas. Eles são melhores em compreender as nuances da linguagem e podem lidar com dados sequenciais de forma mais eficiente. Além disso, o grande número de parâmetros nos LLMs permite raciocínio e recursos preditivos mais sofisticados em comparação com os modelos tradicionais, que eram mais limitados em termos de escopo e escalabilidade. Em última análise, os LLMs oferecem uma abordagem mais matizada e versátil para o processamento e a geração de linguagem.

Quais são os desafios associados ao desenvolvimento e à implementação de LLMs?

O desenvolvimento e a implantação de LLMs apresentam vários desafios, inclusive os recursos computacionais necessários para o treinamento, que podem ser substanciais. Além disso, há preocupações com relação à parcialidade dos dados de treinamento, o que pode levar o modelo a gerar conteúdo preconceituoso ou prejudicial. Problemas de privacidade também surgem devido à sensibilidade dos dados usados no treinamento. Além disso, a interpretabilidade desses modelos representa um desafio, pois seu processo de tomada de decisão é complexo e nem sempre transparente. Por fim, o impacto ambiental do processo de treinamento que consome muita energia é uma preocupação crescente.

Como os modelos de linguagem como o GPT-4 e o Bard afetam o campo da PNL?

Modelos como o GPT-4 e o Bard avançaram significativamente no campo do Processamento de Linguagem Natural ao demonstrar um desempenho sem precedentes em uma ampla gama de tarefas de PLN. Sua capacidade de gerar texto, entender o contexto e produzir respostas semelhantes às humanas definiu novos padrões para o que a IA pode alcançar na compreensão e produção de linguagem. Esses modelos não apenas aprimoraram a qualidade e a eficiência de aplicativos como chatbots, geração de conteúdo e tradução de idiomas, mas também abriram novos caminhos para pesquisa e desenvolvimento em PLN, ampliando os limites dos recursos de IA.

Existe um guia para iniciantes sobre como entender e trabalhar com LLMs?

Sim, para os novatos na área, um guia para iniciantes sobre modelos de linguagem de grande porte pode ser extremamente útil. Em geral, esse guia aborda os conceitos básicos do que são os LLMs, como são treinados e suas aplicações. Ele pode oferecer insights sobre os modelos mais importantes em 2023, explicar a tecnologia subjacente e fornecer exemplos de tarefas de PNL que podem ser realizadas com LLMs. Os iniciantes podem procurar recursos on-line, tutoriais e cursos que ofereçam uma introdução a esses conceitos, ajudando a criar um entendimento básico de como os LLMs funcionam e como podem ser utilizados em vários projetos.