Difusão estável e geradores de imagens DALL-E AI no UberCreate

A geração de imagens de IA é o processo de criação de imagens realistas a partir de textosOs geradores de imagens podem ser usados para gerar imagens, esboços ou outras entradas usando modelos de inteligência artificial (IA). Os geradores de imagens com IA têm muitas aplicações, da arte digital ao marketing, e podem aprimorar projetos de narração de histórias, web design e multimídia. Entretanto, nem todos os geradores de imagens com IA são iguais.

Neste artigo, exploraremos dois dos modelos mais avançados e inovadores de geração de imagens por IA: Difusão estável e DALL-E. Compararemos suas capacidades, recursos e tecnologias e mostraremos como eles podem liberar sua criatividade com o poder da engenharia imediata.

Também discutiremos o cenário de código aberto, as considerações éticas e as tendências futuras da tecnologia de geração de imagens de IA.

Tanto o Stable Diffusion quanto o DALL-E estão na vanguarda de um renascimento digital, transformando a forma como concebemos e criamos arte. Esses modelos generativos de IA democratizaram a expressão artística, permitindo que qualquer pessoa com um computador gere visuais impressionantes a partir de simples instruções de texto. Essa mudança não apenas expande o conjunto de ferramentas dos artistas digitais, mas também convida indivíduos de todas as esferas da vida a explorar sua criatividade sem a necessidade de habilidades artísticas tradicionais.

Por fim, exploraremos UberCriarA ferramenta All in One AI Tool, que mescla DALL-E e Stable Difussion em uma só, e como isso o beneficia.

O que diferencia o Stable Diffusion e o DALL-E no interesse da geração de imagens por IA?

O Stable Diffusion e o DALL-E são dois dos mais recentes e impressionantes modelos de geração de imagens com IA, lançados pela IA de estabilidade e OpenAI respectivamente. Ambos os modelos usam um texto para imagem O que significa que eles podem gerar imagens a partir de descrições de linguagem natural. No entanto, elas diferem em suas arquiteturas, métodos e resultados.

- Difusão estável 3 é um modelo de difusãoou seja, ele gera imagens refinando-as gradualmente a partir de ruídos aleatórios. Ele usa um transformador de difusão para aprender o processo inverso de adicionar ruído a uma imagem e, em seguida, aplica-o de forma inversa para gerar uma nova imagem a partir de um prompt de texto. O Stable Diffusion pode gerar imagens de alta qualidade de até 256×256 pixels de tamanho e pode lidar com solicitações complexas e diversas. Ele também pode executar pinturaIsso significa que ele pode preencher as partes ausentes de uma imagem com uma imagem de entrada e um prompt de texto.

- DALL-E 3 é um modelo de transformadorou seja, ele gera imagens codificando o prompt de texto e decodificando-o em uma imagem. Ele usa um modelo de linguagem grande chamado GPT-3 como codificador de texto, e um rede neural deconvolucional como decodificador de imagem. O DALL-E pode gerar imagens de até 64×64 pixels de tamanho e pode produzir várias imagens para o mesmo prompt. Ele também pode executar tiro zero geração de imagens, o que significa que ele pode gerar imagens para prompts que nunca viu antes.

Comparação dos recursos do modelo de geração de imagens do Stable Diffusion com o DALL-E

Explorando os recursos exclusivos de cada modelo de geração

A integração do DALL-E com o ChatGPT aprimora seus recursos de acompanhamento de solicitações, tornando-o excepcionalmente fácil de usar e eficiente na geração da imagem desejada na primeira tentativa. Por outro lado, a natureza de código aberto do Stable Diffusion e a inclusão de recursos como o ControlNet permitem um nível mais profundo de personalização e experimentação, atendendo tanto a usuários novatos quanto a artistas experientes.

Stability AI vs OpenAI: a tecnologia por trás da magia

No centro desses modelos estão técnicas avançadas de aprendizado de máquina, com ambos aproveitando variações da arquitetura do transformador para processar e gerar imagens complexas a partir de descrições textuais. A principal diferença está na acessibilidade e no uso pretendido; o DALL-E da OpenAI faz parte de um conjunto mais amplo de ferramentas de IA disponíveis por meio de assinatura, enquanto a Stability AI enfatiza o envolvimento da comunidade e a inovação por meio de sua abordagem de código aberto.

Quais são os recursos exclusivos da difusão estável e do DALL-E que os diferenciam no campo da geração de imagens de IA?

Enquanto o Stable Diffusion se destaca por oferecer controle sobre a modificação da imagem e por ser acessível, o DALL-E se destaca por sua interface amigável, qualidade de imagem consistente e recursos de processamento de linguagem natural. A escolha entre esses geradores de imagens de IA depende, em última análise, das preferências específicas do usuário, dos objetivos e do nível de personalização necessário para as tarefas de geração de imagens.

Difusão estável:

- Recursos de pintura: Permite que os usuários ajustem os tamanhos de elementos específicos nas imagens geradas ou os substituam, oferecendo maior controle sobre a modificação da imagem.

- Acessibilidade off-line: Ao contrário de outros geradores de imagens de IA, o Stable Diffusion pode ser baixado e usado off-line, proporcionando flexibilidade no uso.

- Econômico: Oferece um plano básico a partir de $9 por mês, o que o torna uma opção mais econômica em comparação com o DALL-E.

- Versatilidade e potência: Conhecido por sua capacidade de criar imagens de alta qualidade com foco no controle e na personalização do usuário.

DALL-E:

- Interface amigável ao usuário: Requer um nível ligeiramente menor de conhecimento técnico em comparação com o Stable Diffusion, melhorando a acessibilidade para os usuários.

- Qualidade de imagem consistente: Conhecido por gerar consistentemente imagens relevantes e de alta qualidade, garantindo um resultado confiável.

- Recursos de processamento de linguagem natural: Permite que os usuários interajam de forma conversacional com o modelo para refinar os prompts e gerar imagens com base em entradas de texto.

As limitações do Stable Diffusion e do DALL-E na geração de imagens de IA são as seguintes:

Embora ambos os modelos ofereçam recursos avançados na geração de imagens com IA, essas limitações destacam áreas em que são necessárias melhorias ou considerações para aprimorar a experiência do usuário e a qualidade do resultado. Os usuários devem avaliar cuidadosamente essas restrições com base em suas necessidades e preferências específicas ao selecionar um gerador de imagens de IA para seus projetos.

Difusão estável:

- Inconsistência na qualidade da imagem: A difusão estável pode, às vezes, ser imprevisível em termos de qualidade de imagem, levando a uma variabilidade no resultado.

- Exigência de conhecimento técnico: Embora seja fácil de usar, o Stable Diffusion pode exigir um certo nível de conhecimento técnico para o uso ideal, o que pode representar uma barreira para iniciantes.

- Restrições de resolução: O modelo pode enfrentar desafios com deterioração e precisão quando os parâmetros do usuário se desviam da resolução de 512×512 pretendida, afetando a qualidade das imagens criadas.

DALL-E:

- Personalização limitada: O DALL-E pode ter limitações em termos de personalização em comparação com o Stable Diffusion, restringindo potencialmente a capacidade dos usuários de adaptar as imagens a requisitos específicos.

- Considerações éticas: Apesar de sua qualidade de imagem consistente, o DALL-E enfrenta desafios relacionados a possíveis vieses nas imagens geradas e à necessidade de uso responsável para se alinhar às práticas éticas.

- Engenharia de prompts complexos: Os usuários podem encontrar dificuldades na elaboração de prompts de texto precisos que transmitam com exatidão as imagens desejadas, afetando a qualidade e a relevância das imagens geradas.

Os tipos de imagens que o Stable Diffusion e o DALL-E podem gerar diferem em vários aspectos:

O Stable Diffusion se destaca na renderização de vários estilos, oferecendo suporte a inpainting e outpainting e oferecendo amplas opções de personalização; o DALL-E se destaca pela facilidade de uso, pelo foco em imagens abstratas e semelhantes a pinturas e pela saída consistente de alta qualidade. A escolha entre esses modelos depende dos requisitos específicos do usuário, das preferências e do tipo de imagem que se pretende gerar.

Difusão estável:

- Estilos de renderização: O Stable Diffusion é excelente na renderização de uma variedade de estilos, especialmente fotos realistas, melhor do que o DALL-E fora da caixa.

- Inpainting e Outpainting: O Stable Diffusion oferece suporte a inpainting (regeneração de uma parte da imagem, mantendo o restante inalterado) e outpainting (extensão da imagem, preservando o conteúdo original), oferecendo aos usuários mais controle sobre a modificação da imagem.

- Versatilidade: Os usuários podem refinar todos os aspectos da imagem até que ela atenda aos seus padrões, tornando o Stable Diffusion adequado para a criação artística e a personalização.

DALL-E:

- Imagens abstratas e semelhantes a pinturas: O DALL-E é treinado para produzir imagens mais abstratas ou semelhantes a pinturas, destacando-se por responder com eficácia a solicitações menos detalhadas ou mais amplas.

- Facilidade de uso: Conhecido por sua interface amigável e recursos de processamento de linguagem natural, o DALL-E oferece uma experiência perfeita para a geração de imagens com base em avisos simples e naturais.

- Qualidade de imagem consistente: O DALL-E é reconhecido por gerar consistentemente imagens relevantes e de alta qualidade, garantindo uma saída confiável para os usuários.

Pontos fortes e fracos da difusão estável e do DALL-E para casos de uso específicos

Difusão estável:

Pontos fortes:

- Recursos de pintura: Permite que os usuários ajustem elementos específicos em imagens ou os substituam, fornecendo controle sobre as modificações.

- Acessibilidade off-line: Pode ser baixado e usado off-line, oferecendo flexibilidade de uso.

- Versatilidade: Conhecido por renderizar vários estilos, especialmente fotos realistas, e por oferecer suporte à pintura e à remoção de tinta, permitindo uma ampla personalização.

Pontos fracos:

- Inconsistência na qualidade da imagem: Às vezes, pode fornecer qualidade de imagem variável, afetando a confiabilidade da saída.

- Exigência de conhecimento técnico: Embora seja fácil de usar, pode exigir um certo nível de conhecimento técnico para o uso ideal, o que pode representar uma barreira para iniciantes.

- Restrições de resolução: Podem surgir desafios ao se desviar da resolução pretendida, afetando a qualidade da imagem.

DALL-E:

Pontos fortes:

- Interface amigável ao usuário: Requer menos conhecimento técnico em comparação com o Stable Diffusion, melhorando a acessibilidade para os usuários.

- Qualidade de imagem consistente: Conhecido por gerar consistentemente imagens relevantes e de alta qualidade, garantindo um resultado confiável.

- Recursos de processamento de linguagem natural: É excelente em responder a solicitações menos detalhadas ou mais amplas de forma eficaz, tornando a engenharia de solicitações menos crítica.

Pontos fracos:

- Personalização limitada: Pode ter limitações de personalização em comparação com o Stable Diffusion, restringindo potencialmente a capacidade dos usuários de adaptar as imagens a requisitos específicos.

- Considerações éticas: Enfrenta desafios relacionados a possíveis vieses nas imagens geradas e à necessidade de uso responsável para se alinhar às práticas éticas.

- Engenharia de prompts complexos: Os usuários podem encontrar dificuldades na elaboração de prompts de texto precisos que transmitam com exatidão as imagens desejadas, afetando a qualidade e a relevância da imagem.

O Stable Diffusion oferece amplas opções de personalização e versatilidade nos estilos de renderização, enquanto o DALL-E se destaca pela facilidade de uso e pela saída consistente de alta qualidade. A escolha entre esses modelos depende dos requisitos específicos do caso de uso, do nível de conhecimento do usuário e do nível de personalização desejado para as tarefas de geração de imagens.

Casos de uso específicos em que a difusão estável supera o desempenho do DALL-E:

- Recursos de pintura: O Stable Diffusion é excelente em inpainting, permitindo que os usuários ajustem elementos específicos nas imagens ou os substituam, proporcionando maior controle sobre a modificação da imagem.

- Versatilidade na renderização de estilos: O Stable Diffusion tem uma vantagem na renderização de vários estilos, especialmente fotos realistas, superando o DALL-E nesse aspecto.

- Acessibilidade off-line: Ao contrário do DALL-E, o Stable Diffusion pode ser baixado e usado off-line, oferecendo aos usuários flexibilidade e privacidade nas tarefas de geração de imagens.

- Personalização e controle: A difusão estável permite que os usuários refinem cada aspecto da imagem até que ela atenda aos seus padrões, tornando-a ideal para a criação artística e a personalização detalhada em comparação com o DALL-E.

- Custo-benefício: Com um plano básico a partir de $9 por mês, o Stable Diffusion oferece uma opção mais econômica para os usuários em comparação com o DALL-E, tornando-o acessível a uma gama maior de pessoas.

Em resumo, o Stable Diffusion supera o DALL-E em casos de uso específicos, como recursos de pintura, versatilidade em estilos de renderização, acessibilidade off-line, opções de personalização e custo-benefício. Os usuários que buscam maior controle sobre a modificação de imagens, diversos estilos de renderização, uso off-line, personalização detalhada e opções econômicas podem achar o Stable Diffusion mais adequado para suas necessidades de geração de imagens em comparação com o DALL-E.

Alguns casos de uso específicos em que o DALL-E supera o Stable Diffusion incluem:

- Facilidade de uso: O DALL-E exige menos conhecimento técnico em comparação com o Stable Diffusion, tornando-o mais acessível a um público mais amplo.

- Qualidade de imagem consistente: O DALL-E é conhecido por fornecer imagens relevantes e de alta qualidade, garantindo resultados confiáveis.

- Recursos de processamento de linguagem natural: O DALL-E é excelente em responder a solicitações menos detalhadas ou mais amplas de forma eficaz, tornando a engenharia de solicitações menos crítica.

- Velocidade: O DALL-E normalmente é mais rápido na produção de imagens, geralmente três a quatro vezes mais rápido do que a difusão estável sob as mesmas condições.

No entanto, é importante observar que o Stable Diffusion oferece vantagens em casos de uso específicos, como recursos de pintura, acessibilidade off-line, opções de personalização e custo-benefício. Em última análise, a escolha entre o DALL-E e o Stable Diffusion depende dos requisitos específicos do caso de uso, do nível de conhecimento do usuário e dos níveis desejados de personalização e controle das tarefas de geração de imagens.

Como aproveitar o poder da engenharia de prompts para obter uma arte de IA impressionante

Criação de prompts de texto eficazes para imagens desejadas

A arte da engenharia de prompts envolve a criação de entradas de texto que orientam a IA a produzir resultados visuais específicos. Isso requer um equilíbrio entre especificidade e criatividade, garantindo que o prompt seja detalhado o suficiente para transmitir o conceito desejado e, ao mesmo tempo, deixando espaço para os recursos interpretativos da IA.

Entendendo a importância da linguagem precisa na elaboração de prompts

A escolha das palavras em um prompt pode influenciar significativamente a imagem gerada. Os termos que descrevem não apenas o tema, mas também o estilo, o humor e o contexto podem levar a resultados mais precisos e visualmente atraentes.

Dicas e truques para otimizar a saída de imagens por meio do Prompt Engineering

A experimentação é fundamental; o refinamento iterativo dos prompts com base em resultados anteriores pode ajudar a aprimorar a formulação perfeita. Além disso, o aproveitamento dos recursos exclusivos de cada modelo, como a capacidade do DALL-E de gerar variações ou a pintura do Stable Diffusion, pode aprimorar ainda mais o processo criativo.

Navegando no cenário de código aberto: Difusão estável e seu impacto

A importância do código aberto para acelerar a inovação do gerador de imagens de IA

O modelo de código aberto do Stable Diffusion promove um ambiente colaborativo em que desenvolvedores e artistas podem contribuir para sua evolução, o que leva a avanços rápidos e a uma gama diversificada de modelos especializados.

Como começar a usar o modelo de código aberto da Stable Diffusion

O acesso ao Stable Diffusion é simples, com vários guias e recursos disponíveis para ajudar os usuários a configurar o modelo para uso pessoal ou profissional. A comunidade em torno do Stable Diffusion também oferece amplo suporte aos recém-chegados.

Contribuições da comunidade e aprimoramentos para a difusão estável

A comunidade vibrante em torno do Stable Diffusion levou ao desenvolvimento de vários plug-ins, modelos e ferramentas que ampliam seus recursos, permitindo um controle mais sutil do processo de geração de imagens e abrindo novos caminhos para a criatividade.

Explorando os limites da criatividade: Casos de uso de imagens geradas por IA

As imagens geradas por IA têm encontrado aplicações em uma ampla gama de campos, desde arte digital e marketing até web design e projetos multimídia. A capacidade de gerar rapidamente imagens a partir de instruções de texto está revolucionando a criação de conteúdo, permitindo uma narrativa mais dinâmica e soluções de design inovadoras.

Evitando armadilhas comuns: Considerações éticas na geração de imagens por IA

À medida que os geradores de arte com IA se tornam mais comuns, aumentam as preocupações com direitos autorais, criatividade e possibilidade de uso indevido. Tanto a OpenAI quanto a Stability AI implementaram proteções para lidar com esses problemas, mas o uso ético dessas ferramentas continua sendo uma responsabilidade compartilhada entre os usuários.

O futuro da arte da IA: Previsões e tendências na tecnologia de geração de imagens

O rápido avanço dos geradores de imagens de IA sugere um futuro em que a colaboração entre a criatividade humana e as ferramentas de IA se tornará ainda mais perfeita. Prevendo mais aprimoramentos na interpretação imediata, na qualidade da imagem e nas proteções éticas, a fronteira entre a arte gerada por IA e a arte criada por humanos pode continuar a se confundir, anunciando uma nova era de criatividade digital.

Concluindo, Stable Diffusion e DALL-E representam duas extremidades da fronteira de geração de imagens de IA, cada uma com seus pontos fortes e recursos exclusivos. À medida que essas tecnologias evoluem, elas prometem democratizar ainda mais a criação de arte, tornando-a mais acessível e versátil do que nunca.

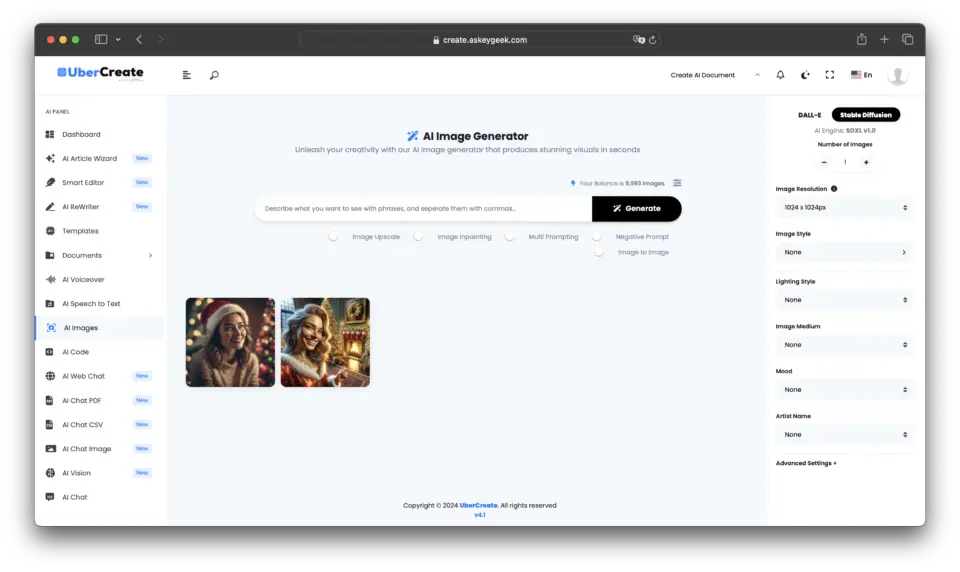

Integrando o melhor dos dois mundos: UberCreate mescla Stable Diffusion e DALL-E

No cenário em constante evolução da geração de imagens com IA, surge uma nova ferramenta que aproveita o poder combinado dos dois modelos de IA mais avançados do setor: UberCreate. Essa plataforma inovadora reúne os recursos do Stable Diffusion e do DALL-E, oferecendo aos usuários uma experiência inigualável na geração de imagens a partir de qualquer descrição.

O poder dos geradores de imagens com IA combinada no UberCreate

O UberCreate é uma prova da sinergia que pode ser obtida quando se combinam os pontos fortes de diferentes tecnologias de IA. Ao integrar a precisão do DALL-E com a flexibilidade do Stable Diffusion, o UberCreate oferece uma solução abrangente para quem deseja gerar imagens de forma rápida e eficiente.

Pino

Pino Principais recursos e funcionalidades do UberCreate

O UberCreate apresenta uma interface intuitiva que simplifica o processo de criação de imagens, tornando-o acessível aos usuários, independentemente de seus conhecimentos técnicos. Com a capacidade de gerar imagens a partir de qualquer descrição, a ferramenta atende a uma ampla gama de necessidades criativas, desde trabalhos de design profissional até projetos de arte pessoal.

Um dos recursos de destaque do UberCreate é o AI Vision Expert, que permite que os usuários carreguem uma imagem e recebam uma análise detalhada de seu conteúdo. Esse recurso pode identificar objetos, pessoas e lugares, bem como discernir detalhes intrincados, fornecendo insights valiosos que podem ser usados para refinar o processo criativo.

Os benefícios de ter a difusão estável e o DALL-E em uma única ferramenta

Ter o Stable Diffusion e o DALL-E no UberCreate significa que os usuários podem aproveitar o melhor dos dois mundos. Não importa se eles precisam dos estilos artísticos diferenciados que a difusão estável oferece ou da alta fidelidade e aderência imediata do DALL-E, o UberCreate pode acomodar essas necessidades sem problemas. Esse recurso duplo garante que as imagens produzidas não sejam apenas visualmente impressionantes, mas também estejam alinhadas com a visão do usuário.

Além disso, a combinação desses modelos em uma única ferramenta reduz significativamente o tempo e o esforço necessários para criar imagens. Os usuários podem gerar imagens em minutos, o que tradicionalmente levaria horas para ser feito à mão ou usando ferramentas separadas. Essa eficiência é inestimável para profissionais que precisam cumprir prazos apertados sem comprometer a qualidade.

Conclusão

O UberCreate representa um avanço significativo na geração de imagens com IA, oferecendo uma ferramenta versátil e avançada que aproveita os pontos fortes combinados do Stable Diffusion e do DALL-E.

Sua interface amigável e seus recursos avançados fazem dele um recurso essencial para artistas, designers e profissionais de criação que buscam ampliar os limites da arte digital e da criação de conteúdo.

Com o UberCreate, as possibilidades são tão ilimitadas quanto a imaginação, permitindo que os usuários deem vida aos seus conceitos visuais mais ambiciosos com facilidade e precisão.

Perguntas frequentes (FAQ)

Quais são as principais diferenças entre o DALL-E e o Stable Diffusion na ferramenta UberCreate?

As principais diferenças entre o DALL-E e o Stable Diffusion na ferramenta UberCreate estão em seus recursos de modelo de texto para imagem e nas técnicas de incorporação de imagens. O DALL-E é excelente na geração de imagens fotorrealistas a partir de descrições de linguagem natural com um processo de inferência refinado e um conjunto de dados aprimorado, o que o torna superior para a criação de imagens precisas e baseadas em legendas. Por outro lado, o Stable Diffusion usa a difusão latente e a incorporação de imagens de clipes para oferecer mais liberdade no processo de difusão para a criação de imagens abstratas ou estilizadas diretamente de solicitações de imagens condicionadas por texto.

Como a integração de DALL-E e Stable Diffusion aprimora a arte gerada por IA no UberCreate?

Ao integrar o DALL-E e o Stable Diffusion, o UberCreate oferece uma plataforma versátil para arte gerada por IA. Essa combinação permite que os usuários aproveitem a capacidade do DALL-E de gerar imagens fotorrealistas com base em descrições detalhadas de linguagem natural e a capacidade do Stable Diffusion de produzir arte exclusiva e estilizada por meio de seu processo de difusão latente. Isso garante que, independentemente da complexidade das imagens que você deseja gerar, o UberCreate oferece uma solução abrangente.

A plataforma combinada DALL-E e Stable Diffusion do UberCreate consegue entender entradas complexas de linguagem natural para a geração de imagens?

Sim, a plataforma combinada do DALL-E e do Stable Diffusion no UberCreate foi projetada para entender entradas complexas de linguagem natural. O modelo avançado de conversão de texto em imagem do DALL-E e o uso inteligente de incorporação de imagens de clipes e conjunto de dados do Stable Diffusion permitem que o sistema interprete e converta descrições complexas em imagens correspondentes, facilitando uma tradução perfeita de legenda em imagem.

Quais são os avanços que o Stable Diffusion oferece em relação ao DALL-E 2 no UberCreate?

O Stable Diffusion oferece vários avanços em relação ao DALL-E 2 no UberCreate, incluindo controle mais flexível sobre o processo de geração de imagens e qualidade de imagem aprimorada. Usando técnicas de difusão estável e incorporação de imagens aprimoradas, o Stable Diffusion pode gerar imagens mais abstratas e estilisticamente diversas do que o modelo de texto para imagem do DALL-E 2. Além disso, o lançamento do Stable Diffusion introduziu um processo de inferência mais eficiente, resultando em tempos de geração mais rápidos e imagens mais refinadas.

Como usar a IA para combinar perfeitamente imagens geradas pelo DALL-E e pela difusão estável no UberCreate?

Para usar a IA para mesclar perfeitamente as imagens geradas pelo DALL-E e pelo Stable Diffusion no UberCreate, os usuários podem empregar o recurso de pintura da plataforma e seus recursos de conjunto de dados. Ao especificar quais aspectos da arte gerada por IA devem vir de um dos modelos, a ferramenta usa de forma inteligente as técnicas de incorporação de imagens e os recursos de geração de imagens condicionais de texto de ambos os modelos para mesclar elementos naturalmente. Essa combinação é facilitada pela compreensão que a IA subjacente tem dos contextos da imagem e das nuances sutis dos detalhes da imagem original.

Qual é a importância da incorporação de imagens de clipes na combinação de DALL-E e difusão estável?

As incorporações de imagens de clipes desempenham um papel crucial na combinação de DALL-E e Stable Diffusion, pois permitem que a IA compreenda e interprete o conteúdo e o estilo das imagens em um nível granular. Isso é essencial ao mesclar imagens geradas por ambos os modelos no UberCreate, pois garante que os elementos de diferentes imagens sejam mesclados de forma coesa. As incorporações de imagens de clipes aproveitam o entendimento da IA sobre o conteúdo da imagem, facilitando uma integração mais precisa e natural das imagens geradas.

O DALL-E e o Stable Diffusion do UberCreate podem gerar imagens a partir do mesmo prompt de linguagem natural de forma diferente?

Sim, ao usar o mesmo prompt de linguagem natural, a DALL-E e a Stable Diffusion podem gerar imagens nitidamente diferentes devido a suas abordagens variadas para a geração de imagens. O DALL-E se concentra na criação de imagens precisas e fotorrealistas que se aproximam da legenda fornecida, aproveitando seu rico conjunto de dados e o modelo avançado de texto para imagem. Por outro lado, o Stable Diffusion pode interpretar o mesmo prompt de forma mais abstrata ou estilística, aproveitando seu processo de difusão e técnicas de geração de imagens latentes. Essa variação demonstra o potencial criativo diversificado do uso da IA no UberCreate.

Como o DALL-E e o Stable Diffusion conseguem produzir imagens precisas e detalhadas a partir de instruções vagas?

O DALL-E e o Stable Diffusion foram projetados para extrair e utilizar as informações mais relevantes até mesmo dos prompts mais vagos, graças aos seus modelos avançados de IA e conjuntos de dados abrangentes. O DALL-E emprega um modelo sofisticado de texto para imagem que pode inferir detalhes e contextos que podem não estar explicitamente mencionados no prompt. O Stable Diffusion, por meio de seu processo de difusão latente e do uso de incorporação de imagens de clipes, preenche as lacunas com base em seu amplo treinamento em diversos conteúdos de imagem. Juntos, eles aplicam inferência, criatividade e compreensão da linguagem natural para gerar imagens detalhadas que se alinham com a intenção do usuário.