Generatori di immagini AI a diffusione stabile e DALL-E in UberCreate

La generazione di immagini AI è il processo di creazione immagini realistiche dal testo, schizzi o altri input che utilizzano modelli di intelligenza artificiale (AI). I generatori di immagini AI hanno molte applicazioni, dall'arte digitale al marketing, e possono migliorare la narrazione, il web design e i progetti multimediali. Tuttavia, non tutti i generatori di immagini AI sono uguali.

In questo articolo esploreremo due dei modelli di generazione di immagini AI più avanzati e innovativi: Diffusione stabile E DALL-E. Confronteremo le loro capacità, caratteristiche e tecnologie e mostreremo come possono liberare la tua creatività con la potenza dell'ingegneria tempestiva.

Discuteremo anche il panorama open source, le considerazioni etiche e le tendenze future nella tecnologia di generazione di immagini AI.

Sia Stable Diffusion che DALL-E sono in prima linea nel rinascimento digitale, trasformando il modo in cui concepiamo e creiamo arte. Questi modelli di intelligenza artificiale generativa hanno democratizzato l’espressione artistica, consentendo a chiunque disponga di un computer di generare immagini straordinarie da semplici istruzioni di testo. Questo cambiamento non solo espande la gamma di strumenti degli artisti digitali, ma invita anche individui di ogni ceto sociale a esplorare la propria creatività senza la necessità di competenze artistiche tradizionali.

Infine, esploreremo UberCreate, uno strumento AI tutto in uno che unisce DALL-E e Stable Difussuion in uno e come ti avvantaggia.

Cosa distingue la diffusione stabile e DALL-E nell’interesse della generazione di immagini AI?

Stable Diffusion e DALL-E sono due dei modelli di generazione di immagini AI più recenti e impressionanti rilasciati da Stabilità dell'intelligenza artificiale E OpenAI rispettivamente. Entrambi i modelli utilizzano a testo in immagine approccio, il che significa che possono generare immagini da descrizioni in linguaggio naturale. Tuttavia, differiscono per architettura, metodi e risultati.

- Diffusione stabile 3 è un modello di diffusione, il che significa che genera immagini raffinandole gradualmente dal rumore casuale. Utilizza a trasformatore di diffusione per apprendere il processo inverso di aggiunta di rumore a un'immagine, quindi applicarlo al contrario per generare una nuova immagine da un messaggio di testo. La diffusione stabile può generare immagini di alta qualità fino a 256×256 pixel in termini di dimensioni e in grado di gestire richieste complesse e diversificate. Può anche eseguire inpittura, il che significa che può riempire le parti mancanti di un'immagine data un'immagine di input e un messaggio di testo.

- DALL-E 3 è un modello di trasformatore, il che significa che genera immagini codificando il prompt di testo e decodificandolo in un'immagine. Utilizza a modello linguistico di grandi dimensioni chiamato GPT-3 come codificatore di testo e a rete neurale deconvoluzionale come decodificatore di immagini. DALL-E può generare immagini fino a 64×64 pixel in termini di dimensioni e può produrre più immagini per lo stesso prompt. Può anche eseguire colpo zero generazione di immagini, il che significa che può generare immagini per suggerimenti che non ha mai visto prima.

Confronto tra le capacità del modello di generazione di immagini di diffusione stabile e DALL-E

Esplorando le caratteristiche uniche di ciascun modello di generazione

L'integrazione di DALL-E con ChatGPT migliora le sue capacità di seguire i suggerimenti, rendendolo eccezionalmente facile da usare ed efficiente nel generare l'immagine desiderata al primo tentativo. Al contrario, la natura open source di Stable Diffusion e l'inclusione di funzionalità come ControlNet consentono un livello più profondo di personalizzazione e sperimentazione, soddisfacendo sia gli utenti alle prime armi che gli artisti esperti.

Stabilità AI vs OpenAI: la tecnologia dietro la magia

Al centro di questi modelli si trovano tecniche avanzate di apprendimento automatico, che sfruttano le variazioni dell’architettura del trasformatore per elaborare e generare immagini complesse da descrizioni testuali. La differenza fondamentale sta nella loro accessibilità e destinazione d'uso; DALL-E di OpenAI fa parte di una suite più ampia di strumenti di intelligenza artificiale disponibili tramite abbonamento, mentre Stability AI enfatizza il coinvolgimento e l'innovazione della comunità attraverso il suo approccio open source.

Quali sono le caratteristiche uniche della diffusione stabile e di DALL-E che li distinguono nel campo della generazione di immagini ai?

Mentre Stable Diffusion eccelle nel fornire controllo sulla modifica delle immagini e sulla convenienza, DALL-E si distingue per la sua interfaccia intuitiva, qualità dell'immagine coerente e capacità di elaborazione del linguaggio naturale. La scelta tra questi generatori di immagini AI dipende in ultima analisi dalle preferenze specifiche dell’utente, dagli obiettivi e dal livello di personalizzazione richiesto per le attività di generazione delle immagini.

Diffusione stabile:

- Funzionalità di re-painting: consente agli utenti di regolare le dimensioni di elementi specifici nelle immagini generate o di sostituirli, offrendo un maggiore controllo sulla modifica delle immagini.

- Accessibilità offline: a differenza di altri generatori di immagini AI, Stable Diffusion può essere scaricato e utilizzato offline, offrendo flessibilità di utilizzo.

- Conveniente: offre un piano base a partire da $9 al mese, rendendolo un'opzione più conveniente rispetto a DALL-E.

– Versatilità e potenza: noto per la sua capacità di creare immagini di alta qualità con particolare attenzione al controllo e alla personalizzazione dell'utente.

DALL-E:

- Interfaccia intuitiva: richiede un livello leggermente inferiore di competenza tecnica rispetto a Stable Diffusion, migliorando l'accessibilità per gli utenti.

- Qualità dell'immagine costante: noto per generare costantemente immagini pertinenti e di alta qualità, garantendo risultati affidabili.

- Funzionalità di elaborazione del linguaggio naturale: consente agli utenti di interagire in modo conversazionale con il modello per perfezionare le istruzioni e generare immagini basate su input di testo.

Le limitazioni di Stable Diffusion e DALL-E nella generazione di immagini AI sono le seguenti:

Sebbene entrambi i modelli offrano funzionalità avanzate nella generazione di immagini AI, queste limitazioni evidenziano aree in cui sono necessari miglioramenti o considerazioni per migliorare l’esperienza dell’utente e la qualità dell’output. Gli utenti dovrebbero valutare attentamente questi vincoli in base alle loro esigenze e preferenze specifiche quando selezionano un generatore di immagini AI per i loro progetti.

Diffusione stabile:

- Incoerenza nella qualità dell'immagine: la diffusione stabile a volte può essere incoerente in termini di qualità dell'immagine, portando a variabilità nell'output.

- Requisiti di competenza tecnica: sebbene facile da usare, Stable Diffusion può richiedere un certo livello di competenza tecnica per un utilizzo ottimale, ponendo potenzialmente una barriera per i principianti.

- Vincoli di risoluzione: il modello potrebbe dover affrontare problemi di deterioramento e precisione quando i parametri utente si discostano dalla risoluzione 512×512 prevista, influenzando la qualità delle immagini create.

DALL-E:

- Personalizzazione limitata: DALL-E potrebbe presentare limitazioni in termini di personalizzazione rispetto a Stable Diffusion, limitando potenzialmente la capacità degli utenti di personalizzare le immagini in base a requisiti specifici.

- Considerazioni etiche: nonostante la qualità dell'immagine costante, DALL-E deve affrontare sfide legate a potenziali pregiudizi nelle immagini generate e alla necessità di un utilizzo responsabile per allinearsi alle pratiche etiche.

- Ingegneria complessa dei suggerimenti: gli utenti potrebbero incontrare difficoltà nel creare suggerimenti di testo precisi che trasmettano accuratamente le immagini desiderate, influenzando la qualità e la pertinenza delle immagini generate.

I tipi di immagini che Stable Diffusion e DALL-E possono generare differiscono sotto diversi aspetti:

Stable Diffusion brilla nel rendering di vari stili, supportando l'inpainting e l'outpainting e offrendo ampie opzioni di personalizzazione, DALL-E si distingue per la sua facilità d'uso, focalizzazione su immagini astratte e simili a dipinti e output coerente di alta qualità. La scelta tra questi modelli dipende dalle esigenze specifiche dell'utente, dalle preferenze e dal tipo di immagini che intendono generare.

Diffusione stabile:

- Stili di rendering: Diffusione stabile eccelle nel rendering di una varietà di stili, in particolare foto realistiche, meglio di DALL-E immediatamente.

- Inpainting e Outpainting: Stable Diffusion supporta sia l'inpainting (rigenerare una parte dell'immagine mantenendo il resto invariato) che l'outpainting (estendere l'immagine preservando il contenuto originale), offrendo agli utenti un maggiore controllo sulla modifica dell'immagine.

- Versatilità: gli utenti possono perfezionare ogni aspetto dell'immagine finché non soddisfa i loro standard, rendendo Stable Diffusion adatto alla creazione artistica e alla personalizzazione.

DALL-E:

- Immagini astratte e simili a dipinti: DALL-E è addestrato per produrre immagini più astratte o simili a dipinti, eccellendo nel rispondere in modo efficace a suggerimenti meno dettagliati o più ampi.

- Facilità d'uso: noto per la sua interfaccia intuitiva e le capacità di elaborazione del linguaggio naturale, DALL-E offre un'esperienza fluida per la generazione di immagini basate su istruzioni semplici e naturali.

- Qualità dell'immagine coerente: DALL-E è noto per la generazione costante di immagini pertinenti e di alta qualità, garantendo risultati affidabili per gli utenti.

Punti di forza e di debolezza della diffusione stabile e DALL-E per casi d'uso specifici

Diffusione stabile:

Punti di forza:

- Funzionalità di re-painting: consente agli utenti di regolare elementi specifici nelle immagini o di sostituirli, fornendo il controllo sulle modifiche.

- Accessibilità offline: può essere scaricato e utilizzato offline, offrendo flessibilità di utilizzo.

- Versatilità: noto per il rendering di vari stili, in particolare foto realistiche, e per il supporto dell'in-painting e dell'outpainting, consentendo un'ampia personalizzazione.

Punti deboli:

- Incoerenza nella qualità dell'immagine: a volte può fornire una qualità dell'immagine variabile, incidendo sull'affidabilità dell'output.

- Requisiti di competenza tecnica: sebbene facile da usare, potrebbe richiedere un certo livello di competenza tecnica per un utilizzo ottimale, ponendo potenzialmente una barriera per i principianti.

- Vincoli di risoluzione: possono sorgere problemi quando si devia dalla risoluzione prevista, influenzando la qualità dell'immagine.

DALL-E:

Punti di forza:

- Interfaccia intuitiva: richiede meno competenze tecniche rispetto a Stable Diffusion, migliorando l'accessibilità per gli utenti.

- Qualità dell'immagine costante: noto per generare costantemente immagini pertinenti e di alta qualità, garantendo risultati affidabili.

- Funzionalità di elaborazione del linguaggio naturale: eccelle nel rispondere in modo efficace a richieste meno dettagliate o più ampie, rendendo la progettazione tempestiva meno critica.

Punti deboli:

- Personalizzazione limitata: potrebbe presentare limitazioni nella personalizzazione rispetto a Diffusione stabile, limitando potenzialmente la capacità degli utenti di personalizzare le immagini in base a requisiti specifici.

- Considerazioni etiche: affronta le sfide legate a potenziali pregiudizi nelle immagini generate e alla necessità di un utilizzo responsabile per allinearsi alle pratiche etiche.

- Ingegneria complessa dei suggerimenti: gli utenti potrebbero incontrare difficoltà nel creare suggerimenti di testo precisi che trasmettano accuratamente le immagini desiderate, incidendo sulla qualità e sulla pertinenza delle immagini.

Stable Diffusion offre ampie opzioni di personalizzazione e versatilità negli stili di rendering, DALL-E si distingue per la facilità d'uso e l'output costante di alta qualità. La scelta tra questi modelli dipende dai requisiti specifici del caso d'uso, dal livello di esperienza dell'utente e dal livello di personalizzazione desiderato per le attività di generazione delle immagini.

Casi d'uso specifici in cui la diffusione stabile supera DALL-E:

- Funzionalità di re-painting: Stable Diffusion eccelle nell'in-painting, consentendo agli utenti di regolare elementi specifici nelle immagini o sostituirli, fornendo un maggiore controllo sulla modifica delle immagini.

- Versatilità negli stili di rendering: La diffusione stabile ha un vantaggio nel rendering di vari stili, in particolare foto realistiche, superando DALL-E in questo aspetto.

- Accessibilità offline: a differenza di DALL-E, Stable Diffusion può essere scaricato e utilizzato offline, offrendo agli utenti flessibilità e privacy nelle attività di generazione delle immagini.

- Personalizzazione e controllo: la diffusione stabile consente agli utenti di perfezionare ogni aspetto dell'immagine fino a quando non soddisfa i loro standard, rendendola ideale per la creazione artistica e la personalizzazione dettagliata rispetto a DALL-E.

- Rapporto costo-efficacia: con un piano base a partire da $9 al mese, Stable Diffusion offre un'opzione più conveniente per gli utenti rispetto a DALL-E, rendendolo accessibile a una gamma più ampia di individui.

In sintesi, Stable Diffusion supera DALL-E in casi d'uso specifici come funzionalità di inpainting, versatilità negli stili di rendering, accessibilità offline, opzioni di personalizzazione e convenienza. Gli utenti che cercano un maggiore controllo sulla modifica delle immagini, diversi stili di rendering, utilizzo offline, personalizzazione dettagliata e opzioni convenienti potrebbero trovare Stable Diffusion più adatto alle loro esigenze di generazione di immagini rispetto a DALL-E.

Alcuni casi d'uso specifici in cui DALL-E supera la diffusione stabile includono:

- Facilità d'uso: DALL-E richiede meno competenze tecniche rispetto a Stable Diffusion, rendendolo più accessibile a un pubblico più ampio.

- Qualità dell'immagine costante: DALL-E è rinomata per la fornitura di immagini pertinenti e di alta qualità, garantendo risultati affidabili.

- Capacità di elaborazione del linguaggio naturale: DALL-E eccelle nel rispondere in modo efficace a richieste meno dettagliate o più ampie, rendendo la progettazione tempestiva meno critica.

- Velocità: DALL-E è in genere più veloce nella produzione di immagini, spesso da tre a quattro volte più veloce della diffusione stabile nelle stesse condizioni.

Tuttavia, è importante notare che Stable Diffusion offre vantaggi in casi d'uso specifici, come funzionalità di inpainting, accessibilità offline, opzioni di personalizzazione e convenienza. In definitiva, la scelta tra DALL-E e Stable Diffusion dipende dai requisiti specifici del caso d'uso, dal livello di esperienza dell'utente e dai livelli desiderati di personalizzazione e controllo per le attività di generazione delle immagini.

Come sfruttare la potenza dell'ingegneria tempestiva per una straordinaria arte basata sull'intelligenza artificiale

Creazione di suggerimenti di testo efficaci per le immagini desiderate

L'arte del prompt engineering implica la creazione di input di testo che guidano l'intelligenza artificiale a produrre risultati visivi specifici. Ciò richiede un equilibrio tra specificità e creatività, garantendo che il suggerimento sia sufficientemente dettagliato da trasmettere il concetto desiderato lasciando spazio alle capacità interpretative dell'intelligenza artificiale.

Comprendere l'importanza di un linguaggio preciso nella creazione rapida

La scelta delle parole in un prompt può influenzare in modo significativo l'immagine generata. Termini che descrivono non solo l'argomento ma anche lo stile, l'umore e il contesto possono portare a risultati più accurati e visivamente accattivanti.

Suggerimenti e trucchi per ottimizzare l'output delle immagini tramite Prompt Engineering

La sperimentazione è fondamentale; Il perfezionamento iterativo dei suggerimenti in base agli output precedenti può aiutare a perfezionare la formulazione perfetta. Inoltre, sfruttare le caratteristiche uniche di ciascun modello, come la capacità di DALL-E di generare variazioni o l'inpainting di Stable Diffusion, può migliorare ulteriormente il processo creativo.

Navigare nel panorama Open Source: diffusione stabile e il suo impatto

L'importanza dell'open source nell'accelerazione dell'innovazione dei generatori di immagini AI

Il modello open source di Stable Diffusion promuove un ambiente collaborativo in cui sviluppatori e artisti possono contribuire alla sua evoluzione, portando a rapidi progressi e una vasta gamma di modelli specializzati.

Come iniziare con il modello open source di Stable Diffusion

L'accesso a Stable Diffusion è semplice, con varie guide e risorse disponibili per aiutare gli utenti a configurare il modello per uso personale o professionale. La comunità attorno a Stable Diffusion fornisce anche ampio supporto ai nuovi arrivati.

Contributi della comunità e miglioramenti alla diffusione stabile

La vivace comunità che circonda Stable Diffusion ha portato allo sviluppo di numerosi plugin, modelli e strumenti che ne estendono le capacità, consentendo un controllo più sfumato sul processo di generazione delle immagini e aprendo nuove strade alla creatività.

Esplorare i confini della creatività: casi d'uso per immagini generate dall'intelligenza artificiale

Le immagini generate dall'intelligenza artificiale hanno trovato applicazioni in un'ampia gamma di campi, dall'arte digitale e il marketing al web design e ai progetti multimediali. La capacità di generare rapidamente immagini da istruzioni di testo sta rivoluzionando la creazione di contenuti, consentendo una narrazione più dinamica e soluzioni di progettazione innovative.

Evitare le insidie comuni: considerazioni etiche nella generazione di immagini AI

Man mano che i generatori di arte basati sull’intelligenza artificiale diventano più diffusi, aumentano le preoccupazioni sul copyright, sulla creatività e sul potenziale uso improprio. Sia OpenAI che Stability AI hanno implementato misure di salvaguardia per affrontare questi problemi, ma l’uso etico di questi strumenti rimane una responsabilità condivisa tra gli utenti.

Il futuro dell'arte AI: previsioni e tendenze nella tecnologia di generazione di immagini

Il rapido progresso dei generatori di immagini basati sull’intelligenza artificiale suggerisce un futuro in cui la collaborazione tra la creatività umana e gli strumenti di intelligenza artificiale diventerà ancora più fluida. Anticipando ulteriori miglioramenti nella pronta interpretazione, nella qualità delle immagini e nelle tutele etiche, il confine tra arte generata dall’intelligenza artificiale e arte creata dall’uomo potrebbe continuare a sfumare, annunciando una nuova era di creatività digitale.

In conclusione, Stable Diffusion e DALL-E rappresentano due punte di diamante della frontiera della generazione di immagini AI, ciascuna con i suoi punti di forza e capacità uniche. Man mano che queste tecnologie si evolvono, promettono di democratizzare ulteriormente la creazione artistica, rendendola più accessibile e versatile che mai.

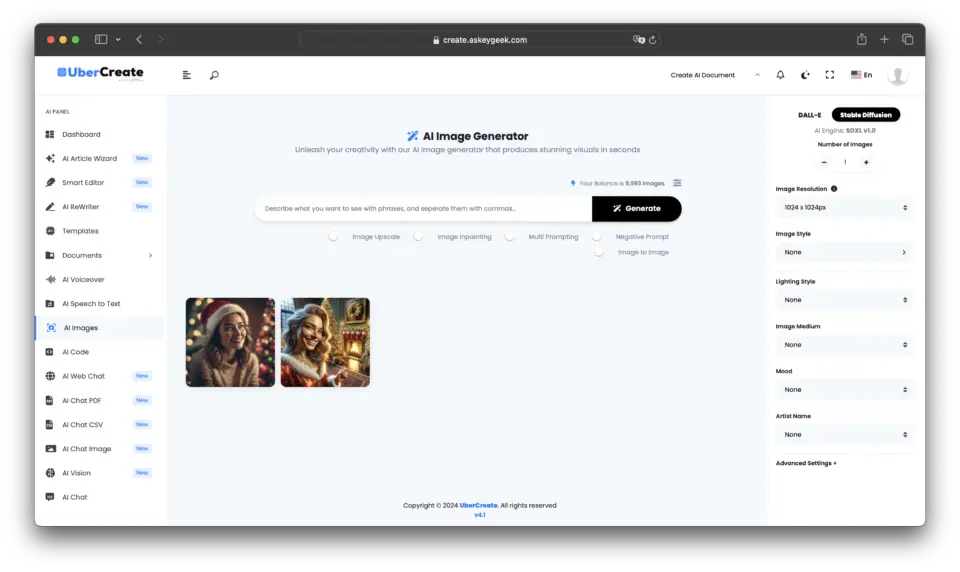

Integrare il meglio di entrambi i mondi: UberCreate unisce Stable Diffusion e DALL-E

Nel panorama in continua evoluzione della generazione di immagini IA, emerge un nuovo strumento che sfrutta la potenza combinata dei due modelli IA più avanzati del settore: UberCreate. Questa piattaforma innovativa riunisce le capacità di Stable Diffusion e DALL-E, offrendo agli utenti un'esperienza senza precedenti nella generazione di immagini da qualsiasi descrizione.

La potenza dei generatori di immagini IA combinati in UberCreate

UberCreate è una testimonianza della sinergia che può essere raggiunta combinando i punti di forza di diverse tecnologie di intelligenza artificiale. Integrando la precisione di DALL-E con la flessibilità di Stable Diffusion, UberCreate fornisce una soluzione completa per chiunque desideri generare immagini in modo rapido ed efficiente.

Spillo

Spillo Principali caratteristiche e funzionalità di UberCreate

UberCreate vanta un'interfaccia intuitiva che semplifica il processo di creazione di immagini, rendendolo accessibile agli utenti indipendentemente dalla loro competenza tecnica. Con la capacità di generare immagini da qualsiasi descrizione, lo strumento soddisfa un'ampia gamma di esigenze creative, dal lavoro di progettazione professionale ai progetti artistici personali.

Una delle caratteristiche distintive di UberCreate è il suo AI Vision Expert, che consente agli utenti di caricare un'immagine e ricevere un'analisi dettagliata del suo contenuto. Questa funzionalità può identificare oggetti, persone e luoghi, nonché discernere dettagli complessi, fornendo preziose informazioni che possono essere utilizzate per perfezionare il processo creativo.

I vantaggi di avere sia la diffusione stabile che DALL-E in un unico strumento

Avere sia Stable Diffusion che DALL-E all'interno di UberCreate significa che gli utenti possono godere del meglio di entrambi i mondi. Sia che richiedano gli stili artistici sfumati offerti da Stable Diffusion o l'alta fedeltà e la pronta aderenza di DALL-E, UberCreate può soddisfare queste esigenze senza problemi. Questa doppia funzionalità garantisce che le immagini prodotte non siano solo visivamente sbalorditive ma anche strettamente allineate alla visione dell'utente.

Inoltre, la combinazione di questi modelli in un unico strumento riduce significativamente il tempo e lo sforzo necessari per creare immagini. Gli utenti possono generare immagini in pochi minuti, cosa che tradizionalmente richiederebbe ore per essere realizzate a mano o utilizzando strumenti separati. Questa efficienza è preziosa per i professionisti che devono rispettare scadenze ravvicinate senza compromettere la qualità.

Conclusione

UberCreate rappresenta un significativo passo avanti nella generazione di immagini AI, fornendo uno strumento versatile e potente che sfrutta i punti di forza combinati di Stable Diffusion e DALL-E.

La sua interfaccia intuitiva e le funzionalità avanzate lo rendono una risorsa essenziale per artisti, designer e creativi che cercano di ampliare i confini dell'arte digitale e della creazione di contenuti.

Con UberCreate, le possibilità sono illimitate quanto l'immaginazione, consentendo agli utenti di dare vita ai loro concetti visivi più ambiziosi con facilità e precisione.

Domande frequenti (FAQ)

Quali sono le differenze principali tra DALL-E e Stable Diffusion nello strumento UberCreate?

Le differenze principali tra DALL-E e Stable Diffusion all'interno dello strumento UberCreate risiedono nelle capacità del modello da testo a immagine e nelle tecniche di incorporamento delle immagini. DALL-E eccelle nel generare immagini fotorealistiche da descrizioni in linguaggio naturale con un processo di inferenza raffinato e un set di dati migliorato, che lo rendono superiore per la creazione di immagini precise e basate su didascalie. Al contrario, la diffusione stabile utilizza la diffusione latente e gli incorporamenti di immagini clip per offrire maggiore libertà nel processo di diffusione per creare immagini astratte o stilizzate direttamente da prompt di immagini condizionali al testo.

In che modo l'integrazione di DALL-E e Stable Diffusion migliora la grafica generata dall'intelligenza artificiale in UberCreate?

Integrando DALL-E e Stable Diffusion, UberCreate offre una piattaforma versatile per l'arte generata dall'intelligenza artificiale. Questa combinazione consente agli utenti di sfruttare la capacità di DALL-E di generare immagini fotorealistiche basate su descrizioni dettagliate in linguaggio naturale e la capacità di Stable Diffusion di produrre arte unica e stilizzata attraverso il suo processo di diffusione latente. Ciò garantisce che, indipendentemente dalla complessità delle immagini che desideri generare, UberCreate fornisca una soluzione completa.

La piattaforma combinata DALL-E e Stable Diffusion di UberCreate è in grado di comprendere input complessi del linguaggio naturale per la generazione di immagini?

Sì, la piattaforma combinata di DALL-E e Stable Diffusion in UberCreate è progettata per comprendere input complessi in linguaggio naturale. Il modello avanzato testo-immagine di DALL-E e l'uso intelligente degli incorporamenti di immagini clip e del set di dati da parte di Stable Diffusion consentono al sistema di interpretare e convertire descrizioni complesse in immagini corrispondenti, facilitando una traduzione continua da didascalia a immagine.

Quali miglioramenti offre Stable Diffusion rispetto a DALL-E 2 in UberCreate?

Stable Diffusion offre diversi miglioramenti rispetto a DALL-E 2 all'interno di UberCreate, incluso un controllo più flessibile sul processo di generazione delle immagini e una migliore qualità delle immagini. Utilizzando tecniche di diffusione stabile e incorporamenti di immagini migliorati, Diffusione stabile può generare immagini più astratte e stilisticamente diverse rispetto al modello testo-immagine di DALL-E 2. Inoltre, il rilascio di Stable Diffusion ha introdotto un processo di inferenza più efficiente, con conseguenti tempi di generazione più rapidi e immagini più rifinite.

Come si utilizza l'intelligenza artificiale per fondere perfettamente le immagini generate da DALL-E e Stable Diffusion in UberCreate?

Per utilizzare l'intelligenza artificiale per fondere perfettamente le immagini generate da DALL-E e Stable Diffusion in UberCreate, gli utenti possono utilizzare la funzionalità di inpainting della piattaforma e le sue capacità di set di dati. Specificando quali aspetti dell'arte generata dall'intelligenza artificiale dovrebbero provenire da uno dei due modelli, lo strumento utilizza in modo intelligente le tecniche di incorporamento delle immagini e le capacità di generazione di immagini condizionali al testo di entrambi i modelli per unire gli elementi in modo naturale. Questa fusione è facilitata dalla comprensione da parte dell'intelligenza artificiale dei contesti delle immagini e delle sottili sfumature dei dettagli dell'immagine originale.

Qual è il significato degli incorporamenti di immagini clip nella combinazione di DALL-E e Stable Diffusion?

Gli incorporamenti di immagini clip svolgono un ruolo cruciale nella combinazione DALL-E e Stable Diffusion, poiché consentono all'intelligenza artificiale di comprendere e interpretare il contenuto e lo stile delle immagini a livello granulare. Ciò è essenziale quando si fondono immagini generate da entrambi i modelli in UberCreate, poiché garantisce che gli elementi di immagini diverse siano uniti in modo coeso. Gli incorporamenti di immagini clip sfruttano la comprensione dell'intelligenza artificiale del contenuto dell'immagine, facilitando un'integrazione più accurata e naturale delle immagini generate.

DALL-E e Stable Diffusion di UberCreate possono generare immagini dallo stesso linguaggio naturale in modo diverso?

Sì, quando si utilizza lo stesso prompt in linguaggio naturale, DALL-E e Stable Diffusion possono generare immagini nettamente diverse a causa dei loro diversi approcci alla generazione delle immagini. DALL-E si concentra sulla creazione di immagini precise e fotorealistiche che corrispondono perfettamente alla didascalia fornita, sfruttando il suo ricco set di dati e il modello avanzato da testo a immagine. Al contrario, la Diffusione Stabile potrebbe interpretare lo stesso suggerimento in modo più astratto o stilistico, sfruttando il suo processo di diffusione e le tecniche di generazione di immagini latenti. Questa variazione dimostra il diverso potenziale creativo dell'utilizzo dell'intelligenza artificiale all'interno di UberCreate.

In che modo DALL-E e Stable Diffusion riescono a produrre immagini accurate e dettagliate da istruzioni vaghe?

DALL-E e Stable Diffusion sono progettati per estrarre e utilizzare le informazioni più rilevanti anche dai suggerimenti più vaghi, grazie ai loro modelli di intelligenza artificiale avanzati e a set di dati completi. DALL-E utilizza un sofisticato modello testo-immagine in grado di dedurre dettagli e contesto che potrebbero non essere esplicitamente menzionati nel prompt. Stable Diffusion, attraverso il suo processo di diffusione latente e l'uso di incorporamenti di immagini clip, colma le lacune attingendo alla sua vasta formazione su diversi contenuti di immagini. Insieme, applicano deduzione, creatività e comprensione del linguaggio naturale per generare immagini dettagliate in linea con le intenzioni dell'utente.