Le guide ultime des grands modèles de langages populaires

Imaginez que vous avez du mal à écrire l'histoire parfaite, vos doigts survolant le clavier tandis que la page blanche vous nargue. Soudain, vous vous souvenez de votre arme secrète : un grand modèle de langage (LLM). Avec quelques invites, le LLM tisse un conte si captivant qu’on dirait de la magie. Ce n’est qu’un exemple de la puissance des LLM, des systèmes d’IA sophistiqués qui remodèlent la façon dont nous interagissons avec la technologie.

Dans le monde en constante évolution et intrigant de l’intelligence artificielle (IA), les grands modèles de langage (LLM) ont fait des vagues grâce à leurs capacités impressionnantes à gérer le langage humain. Mais que sont exactement ces LLM et comment révolutionnent-ils nos interactions et nos tâches quotidiennes ? Plongeons dans ce domaine captivant et découvrons certains des LLM les plus importants qui façonnent l'avenir de l'IA.

Comprendre les grands modèles de langage

Les LLM sont des modèles avancés d'apprentissage automatique qui prédisent et génèrent du texte de type humain. Ils peuvent compléter automatiquement des phrases, traduire des langues et même rédiger des articles entiers. Ces modèles ont évolué de simples prédicteurs de mots à des systèmes complexes capables de gérer des paragraphes et des documents.

Comment fonctionnent les grands modèles de langage ?

Les LLM estiment la probabilité de séquences de mots, en utilisant de vastes ensembles de données pour apprendre les modèles linguistiques. Ils sont construits sur des architectures telles que Transformers, qui se concentrent sur les parties les plus pertinentes de l'entrée pour traiter efficacement des séquences plus longues.

L'évolution des LLM : du BERT au GPT-4

Exemples de grands modèles de langage en action

ChatGPT, une variante des modèles GPT d'OpenAI, est devenu un nom bien connu, alimentant des chatbots qui offrent des interactions de type humain.

Impact du BERT sur les tâches de traitement du langage naturel

BERT a considérablement amélioré les performances des tâches de traitement du langage naturel, telles que l'analyse des sentiments et la traduction linguistique.

GPT-3 et la frontière de la génération de texte

La capacité de GPT-3 à générer un texte créatif et cohérent a ouvert de nouvelles possibilités dans la création de contenu et au-delà.

Une aide-mémoire pour la comparaison des grands modèles de langage actuels

Pour mieux saisir l'ampleur et la diversité des grands modèles linguistiques, examinons de plus près certains des modèles accessibles au public les plus influents qui dominent actuellement le paysage. Chaque modèle apporte des atouts uniques et excelle dans divers cas d’utilisation.

Ce tableau donne un aperçu rapide de certains des grands modèles de langage les plus influents en 2024. BERT, introduit par Google, est connu pour son architecture basée sur des transformateurs et a constitué une avancée significative dans les tâches de traitement du langage naturel. Claude, développé par Anthropic, se concentre sur l'IA constitutionnelle, dans le but de rendre les résultats de l'IA utiles, inoffensifs et précis. Adhérer, un LLM d'entreprise, propose une formation personnalisée et des réglages précis pour les cas d'utilisation spécifiques de l'entreprise. Ernie, de Baidu, possède 10 000 milliards de paramètres et est conçu pour exceller en mandarin, mais est également capable dans d'autres langues.

LLM locaux vs LLM cloud

Alors que les LLM basés sur le cloud offrent des capacités impressionnantes, une tendance croissante est l'utilisation de l'inférence locale avec des modèles open source. Des outils comme LM Studio permettent aux utilisateurs d'exécuter exécuter des LLM localement directement sur leurs machines.

Cette approche donne la priorité à la confidentialité en conservant toutes les données et tous les traitements hors ligne. Cependant, l’inférence locale nécessite généralement un matériel plus puissant et peut limiter l’accès aux modèles les plus avancés en raison de leur taille.

Top 15 des grands modèles de langage les plus populaires

| Nom du modèle | Taille (Paramètres) | Open source? | Dernière mise à jour (estimation) | Entreprise | Pays de développement |

| AI21 Studios Jurassic-1 Jumbo | 178B | Oui | décembre 2022 | AI21 Studios | Israël |

| Google Gemme | 2B ou 7B | Oui | mai 2023 | Google IA | États-Unis |

| Méta LLaMA 13B | 13B | Oui | Début 2023 | Méta-IA | États-Unis |

| Méta LLaMA 7B | 7B | Oui | Début 2023 | Méta-IA | États-Unis |

| EleutherAI GPT-J | 6B | Oui | Mai 2023 (par le biais de fourches comme Dolly 2) | EleutherAI (groupe de recherche) | États-Unis |

| La pile - EleutherAI | 900 Go de données textuelles | Oui | Développement continu | EleutherAI (groupe de recherche) | États-Unis |

| Mistral AI - Mistral Large | Non divulgué publiquement (Large) | Open-source avec options payantes | septembre 2023 | Mistral AI | France |

| Falcon 180B | 180B | Oui | Non spécifié | Institut d'innovation technologique | EAU |

| BERT | 342 millions d'euros | Non | Juillet 2018 | Google IA | États-Unis |

| Ernie | 10 milliards | Non | août 2023 | Baidu | Chine |

| OpenAI GPT-3.5 | 175B | Non | Fin 2022 | OpenAI | États-Unis |

| Claude | Non spécifié | Non | Non spécifié | Anthropique | États-Unis |

| Adhérer | Non divulguée publiquement (massive) | Non | Développement continu | Adhérer | Canada |

| Google PaLM (axe de recherche) | Non divulgué publiquement (probablement très important) | Non | En cours de développement | Google IA | États-Unis |

| OpenAI GPT-4 | Non divulgué publiquement (Successeur de GPT-3.5) | Non | En cours de développement | OpenAI | États-Unis |

Comparaison des pays de développement des LLM

Si l'on compare les 15 premiers grands modèles linguistiques (LLM), les États-Unis contribuent pour près de 67% à la part de marché du développement des LLM pour 10 des 15 modèles.

| Pays de développement | Nombre de modèles |

| Canada | 1 |

| Chine | 1 |

| France | 1 |

| Israël | 1 |

| EAU | 1 |

| États-Unis | dix |

| Total général | 15 |

Architectures et méthodes de formation LLM

| Architecture/Méthode | Description |

|---|---|

| Transformateur | Architecture de réseau neuronal qui s'appuie sur des mécanismes d'attention pour améliorer l'efficacité et la précision du traitement des données séquentielles. C'est la base de nombreux LLM modernes. |

| Préformation | L'étape initiale de la formation d'un LLM consiste à l'exposer à une grande quantité de données textuelles non étiquetées afin d'apprendre les modèles statistiques et les structures de la langue. |

| Mise au point | Affiner un modèle pré-entraîné en l'entraînant sur des données spécifiques liées à une tâche particulière, afin d'améliorer ses performances pour cette tâche. |

| QLoRA | Une méthode impliquant la rétropropagation de gradients via un modèle de langage pré-entraîné quantifié sur 4 bits gelé dans des adaptateurs de bas rang (LoRA), permettant un réglage fin efficace. |

L'architecture du transformateur a révolutionné le domaine du traitement du langage naturel en permettant aux modèles de gérer plus efficacement de longues séquences de données. La pré-formation et la mise au point sont des étapes critiques dans le développement des LLM, leur permettant d'apprendre à partir de grandes quantités de données, puis de se spécialiser dans des tâches spécifiques. QLoRA représente une technique avancée pour affiner les LLM, réduisant les demandes de mémoire tout en maintenant les performances

Cas d'utilisation clés pour les grands modèles de langage

Comment les LLM révolutionnent la traduction linguistique et l'analyse des sentiments

Les LLM ont transformé la traduction linguistique en comprenant et en traduisant de grandes quantités de données, tandis que l'analyse des sentiments est devenue plus nuancée grâce à leurs capacités d'apprentissage en profondeur.

Améliorer les interactions homme-machine avec les chatbots

Les chatbots alimentés par LLM offrent un support client personnalisé et efficace, changeant le visage du service client.

Transformer la création de contenu grâce à l'IA générative

Les modèles d’IA générative comme GPT-3 ont permis de créer rapidement du contenu de haute qualité, aidant ainsi les rédacteurs et les concepteurs.

Défis et limites de la mise en œuvre des LLM

Répondre aux préoccupations concernant les préjugés et l’utilisation éthique

Les données de formation pour les LLM peuvent introduire des biais, soulevant des problèmes éthiques qui doivent être résolus.

Comprendre les coûts de calcul de la formation de grands modèles

La formation des LLM nécessite des ressources informatiques importantes, ce qui peut être coûteux et non durable sur le plan environnemental.

Les limites de la compréhension du langage et de la saisie du contexte

Malgré leurs capacités, les LLM ont encore du mal à comprendre le contexte et les subtilités du langage humain.

Comment les grands modèles linguistiques sont formés et affinés

L'importance de grandes quantités de données dans les LLM de pré-formation

Les LLM nécessitent de grands ensembles de données pour apprendre un large éventail de modèles et de nuances linguistiques.

Techniques de réglage fin pour des applications spécifiques

Des techniques telles que l'apprentissage par transfert et le réglage fin avec des modèles de transformateur sont utilisées pour adapter les LLM à des tâches spécifiques.

Émergence de modèles de base dans l'apprentissage automatique

Les modèles de base constituent une nouvelle tendance en matière d'apprentissage automatique, fournissant une base pour la création de modèles spécialisés.

Différences entre la pré-formation et la formation spécifique à une tâche

La pré-formation et la formation spécifique à une tâche (souvent appelée mise au point) sont deux phases critiques dans le développement de grands modèles de langage (LLM). Ces étapes sont fondamentales pour la façon dont les LLM comprennent et génèrent un texte de type humain, chacune servant un objectif distinct dans le processus d'apprentissage du modèle.

LLM pré-formation

La pré-formation est la phase initiale et approfondie au cours de laquelle un LLM apprend à partir d'un vaste corpus de données textuelles. Cette étape revient à donner au modèle une large éducation sur la langue, la culture et les connaissances générales. Voici les aspects clés de la pré-formation :

- Base de connaissances générales: Le modèle développe une compréhension de la grammaire, des expressions idiomatiques, des faits et du contexte en analysant un large corpus de texte. Cette large base de connaissances permet au modèle de générer des réponses cohérentes et contextuellement appropriées.

- Apprentissage par transfert: Les modèles pré-entraînés peuvent appliquer leurs modèles de langage appris à de nouveaux ensembles de données, particulièrement utiles pour les tâches avec des données limitées. Cette capacité réduit considérablement le besoin de données détaillées spécifiques à une tâche.

- Rentabilité: Malgré les ressources informatiques importantes requises pour la pré-formation, le même modèle peut être réutilisé dans diverses applications, ce qui en fait une approche rentable.

- Flexibilité et évolutivité: La large compréhension acquise lors de la pré-formation permet d'adapter le même modèle à des tâches diverses. De plus, à mesure que de nouvelles données deviennent disponibles, les modèles pré-entraînés peuvent être davantage entraînés pour améliorer leurs performances.

Formation spécifique à une tâche (mise au point)

Après la pré-formation, les modèles subissent un réglage fin, où ils sont formés sur des ensembles de données plus petits et spécifiques à une tâche. Cette phase adapte les vastes connaissances du modèle pour qu'il soit performant sur des tâches particulières. Les principaux aspects du réglage fin comprennent :

- Spécialisation des tâches: Le réglage fin adapte les modèles pré-entraînés à des tâches ou des secteurs spécifiques, améliorant ainsi leurs performances sur des applications particulières.

- Efficacité et rapidité des données: Étant donné que le modèle a déjà appris des modèles de langage généraux lors de la pré-formation, le réglage fin nécessite moins de données et de temps pour spécialiser le modèle pour des tâches spécifiques.

- Personnalisation du modèle: Le réglage fin permet de personnaliser le modèle pour l'adapter aux exigences uniques de différentes tâches, le rendant ainsi hautement adaptable aux applications de niche.

- Efficacité des ressources: Le réglage fin est particulièrement bénéfique pour les applications disposant de ressources informatiques limitées, car il exploite le gros du travail effectué lors de la pré-formation.

En résumé, la pré-formation permet aux LLM d'acquérir une large compréhension de la langue et des connaissances générales, tandis que le perfectionnement permet d'adapter ces connaissances pour exceller dans des tâches spécifiques. La pré-formation pose les bases des capacités linguistiques du modèle, et le réglage fin optimise ces capacités pour les applications ciblées, en équilibrant la généralisation et la spécialisation du modèle.

L'avenir des grands modèles de langage

Anticiper les LLM de nouvelle génération : GPT-4 et au-delà

La prochaine génération de LLM, comme GPT-4, devrait repousser encore plus loin les limites de ce qui est possible en matière d'IA.

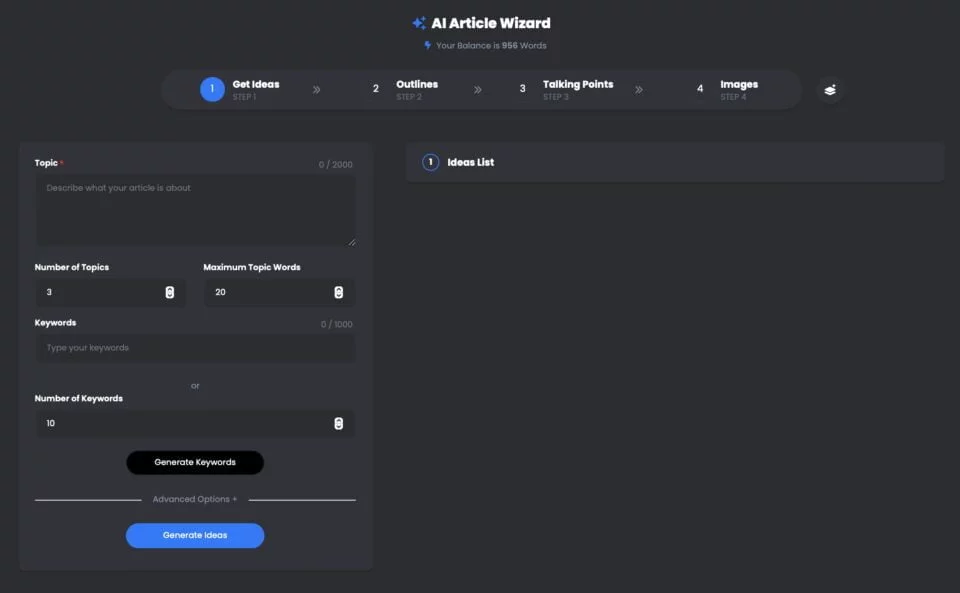

Assistant d'article UberCreate AI est un outil puissant qui exploite le grand modèle de langage (LLM) OpenAI GPT-4 pour générer des articles de haute qualité en quelques minutes.

Avec UberCreate, vous pouvez dire adieu au blocage de l'écrivain et bonjour à un article détaillé en quelques minutes. Il vous suffit de fournir un sujet, un mot-clé et un nombre de mots cible, et UberCreate s'occupera du reste. Il générera un plan d'article, des points de discussion, des images pertinentes et un article final prêt à être publié.

Assistant d'article UberCreate AI utilisant GPT-4

Épingle

Épingle UberCreate utilise une technologie avancée d'intelligence artificielle pour créer un contenu original, engageant et informatif. Il peut écrire sur n’importe quel sujet, des affaires et du marketing à la santé et au mode de vie. Il peut également s'adapter à différents tons, styles et formats, selon vos préférences et vos besoins.

UberCreate n'est pas seulement un générateur de contenu, mais aussi un exhausteur de contenu. Il peut vous aider à améliorer vos articles existants en ajoutant plus de détails, de faits et d'images. Il peut également vérifier votre grammaire, votre orthographe et votre lisibilité, et suggérer des moyens d'optimiser votre contenu pour le référencement et les réseaux sociaux.

UberCreate est le seul outil de création de contenu IA dont vous aurez besoin. Il combine 17 outils d'IA en un, dont un générateur d'articles de blog, un générateur de contenu pour réseaux sociaux, un générateur de contenu visuel, et bien plus encore. Il est conçu pour faciliter tous les aspects de la création de contenu, de l'idéation à la production.

Que vous soyez un blogueur, un spécialiste du marketing, un étudiant ou un professionnel, UberCreate peut vous aider à économiser du temps, de l'argent et des efforts dans la création de contenu de haute qualité. Vous pouvez l'essayer gratuitement et constater les résultats par vous-même.

Repousser les limites de la collaboration homme-IA

LLM devraient améliorer la collaboration entre les humains et l’IA, rendant les interactions plus naturelles et plus productives.

Ces importants LLM ne sont que la pointe de l'iceberg lorsqu'il s'agit de comprendre le vaste potentiel des grands modèles de langage pour révolutionner nos interactions avec la technologie et repousser les limites de la collaboration homme-IA. Restez à l'écoute pour la deuxième partie de cette série, où nous approfondirons les capacités des grands modèles de langage, leurs applications dans divers secteurs et les défis liés à l'exploitation de leur puissance.

Perspectives de compréhension du langage naturel dans la décennie à venir

L’avenir s’annonce prometteur pour la compréhension du langage naturel, les LLM devenant de plus en plus sophistiqués et intégrés dans diverses applications.

En conclusion, les LLM comme BERT, GPT-3 et leurs successeurs révolutionnent les secteurs, de l'éducation aux soins de santé. Alors que nous continuons à exploiter leur pouvoir, nous devons également relever les défis qu’ils présentent, en garantissant leur utilisation éthique et responsable. Le voyage dans le monde des grands modèles de langage ne fait que commencer, et les possibilités sont aussi vastes que les ensembles de données dont ils tirent des enseignements. Plongez dans ce domaine passionnant et façonnons ensemble l’avenir de l’IA.

Foire aux questions (FAQ)

Qu'est-ce qu'un grand modèle linguistique (LLM) dans le contexte du NLP ?

Dans le cadre du traitement du langage naturel (NLP), un grand modèle de langage (LLM) désigne un système d'intelligence artificielle avancé conçu pour comprendre, interpréter et générer des textes de type humain. Ces modèles sont formés sur de grandes quantités de données, ce qui leur permet d'effectuer un large éventail de tâches linguistiques. Grâce au processus de formation, le modèle apprend à prédire le mot suivant dans une phrase, ce qui l'aide à générer à la demande un texte cohérent et pertinent sur le plan contextuel.

Quels sont les différents types de LLM disponibles en 2024 ?

En 2024, plusieurs types de grands modèles de langage seront disponibles, chacun avec des capacités uniques. Les plus remarquables sont des modèles tels que GPT-4, connu pour ses capacités de génération de texte, et Bard, l'homologue de Google, qui se concentre sur un large éventail de tâches NLP. Ces modèles diffèrent par le nombre de paramètres, les données sur lesquelles ils ont été formés et leurs applications spécifiques, qui vont de la simple génération de texte à des tâches complexes de compréhension du langage.

Comment les LLM sont-ils formés sur de grands ensembles de données ?

Les LLM sont formés à l'aide de vastes ensembles de données collectées sur l'internet, notamment des livres, des articles et des sites web. Ce processus d'entraînement intensif consiste à alimenter le modèle avec de grandes quantités de données textuelles, ce qui l'aide à identifier des modèles, à comprendre le contexte et à apprendre des structures linguistiques. Le processus de formation peut prendre des semaines, voire des mois, en fonction de la taille du modèle et des ressources informatiques disponibles. L'objectif est de permettre au modèle de générer des textes qui ne se distinguent pas de ceux écrits par des humains.

Pouvez-vous expliquer les applications des LLM dans les tâches quotidiennes ?

Les LLM peuvent être utilisés dans une variété d'applications pour simplifier et automatiser les tâches quotidiennes. Cela inclut les chatbots et les assistants virtuels pour le service client, les outils de création de contenu pour générer des articles ou des rapports, et les services de traduction pour convertir le texte entre les langues. D'autres applications concernent l'analyse des sentiments pour évaluer l'opinion publique sur les médias sociaux, les outils de résumé pour condenser de longs documents en versions plus courtes, et même les assistants de codage pour aider les programmeurs en générant des extraits de code. Les LLM ont essentiellement révolutionné la manière dont nous interagissons avec la technologie, en la rendant plus intuitive et plus humaine.

En quoi les capacités des grands modèles linguistiques diffèrent-elles des modèles traditionnels ?

Les grands modèles de langage sont nettement plus performants que les modèles traditionnels à plusieurs égards. Tout d'abord, grâce à leur formation approfondie sur divers ensembles de données, les LLM peuvent générer des réponses plus cohérentes, variées et adaptées au contexte. Ils comprennent mieux les nuances du langage et peuvent traiter des données séquentielles plus efficacement. En outre, le nombre même de paramètres dans les LLM permet un raisonnement plus sophistiqué et des capacités prédictives par rapport aux modèles traditionnels, qui étaient plus limités en termes de portée et d'évolutivité. En fin de compte, les LLM offrent une approche plus nuancée et plus polyvalente du traitement et de la génération du langage.

Quels sont les défis associés à l'élaboration et au déploiement des MFT ?

Le développement et le déploiement des LLM posent plusieurs problèmes, notamment les ressources informatiques nécessaires à la formation, qui peuvent être considérables. En outre, il existe des préoccupations concernant la partialité des données d'apprentissage, qui peuvent conduire le modèle à générer un contenu préjudiciable ou nuisible. La sensibilité des données utilisées pour la formation pose également des problèmes de protection de la vie privée. En outre, l'interprétabilité de ces modèles pose problème, car leur processus de prise de décision est complexe et pas toujours transparent. Enfin, l'impact environnemental du processus de formation, qui consomme beaucoup d'énergie, est une préoccupation croissante.

Quel est l'impact de modèles linguistiques tels que GPT-4 et Bard sur le domaine du NLP ?

Des modèles tels que GPT-4 et Bard ont fait progresser de manière significative le domaine du traitement du langage naturel en démontrant des performances sans précédent dans un large éventail de tâches de traitement du langage naturel. Leur capacité à générer du texte, à comprendre le contexte et à produire des réponses de type humain a établi de nouvelles normes pour ce que l'IA peut accomplir en matière de compréhension et de production du langage. Ces modèles ont non seulement amélioré la qualité et l'efficacité d'applications telles que les chatbots, la génération de contenu et la traduction, mais ils ont également ouvert de nouvelles voies pour la recherche et le développement dans le domaine du NLP, repoussant ainsi les limites des capacités de l'IA.

Existe-t-il un guide du débutant permettant de comprendre et de travailler avec les MLD ?

Oui, pour ceux qui débutent dans le domaine, un guide du débutant sur les grands modèles de langage peut être incroyablement utile. Un tel guide couvre généralement les bases de ce que sont les LLM, la manière dont ils sont formés et leurs applications. Il peut donner un aperçu des modèles les plus importants en 2023, expliquer la technologie sous-jacente et fournir des exemples de tâches de TAL pouvant être effectuées avec des LLM. Les débutants peuvent rechercher des ressources en ligne, des tutoriels et des cours qui offrent une introduction à ces concepts, aidant à construire une compréhension fondamentale du fonctionnement des LLM et de la manière dont ils peuvent être utilisés dans divers projets.