¿Qué es PaLM?

Caminos Modelo lingüístico o Palmera, es un modelo de Google que utiliza una complicada arquitectura Transformer con 540 mil millones de decodificadores como únicas entradas. Fue entrenado utilizando el sistema Pathways de Google, que le permite gestionar varias tareas a la vez, adquirir rápidamente nuevas habilidades y reflejar una visión más completa del entorno. Palmera tiene la capacidad de producir texto en una variedad de idiomas y formatos, incluidos gráficos, código y lenguaje natural.

¿Qué es GPT?

Transformador generativo preentrenado (GPT) es un grupo de Modelos de IA creado por OpenAI que utiliza una arquitectura Transformer con varios números de parámetros. Se utilizó un enorme conjunto de datos multimodal que comprende páginas web, libros, fotografías, vídeos, podcasts y más para entrenar la versión más reciente, GPT-4, que tiene 1,5 billones de parámetros.

Aunque necesita más ajustes para tareas particulares, GPT-4 también puede producir texto en múltiples idiomas y dominios. UberCrear es una versión mejorada de los modelos GPT 3.5 y GPT 4 de OpenAI que realiza múltiples tareas como creación de contenido AI, Generación de código AI, Generación de imágenes AI, etc.

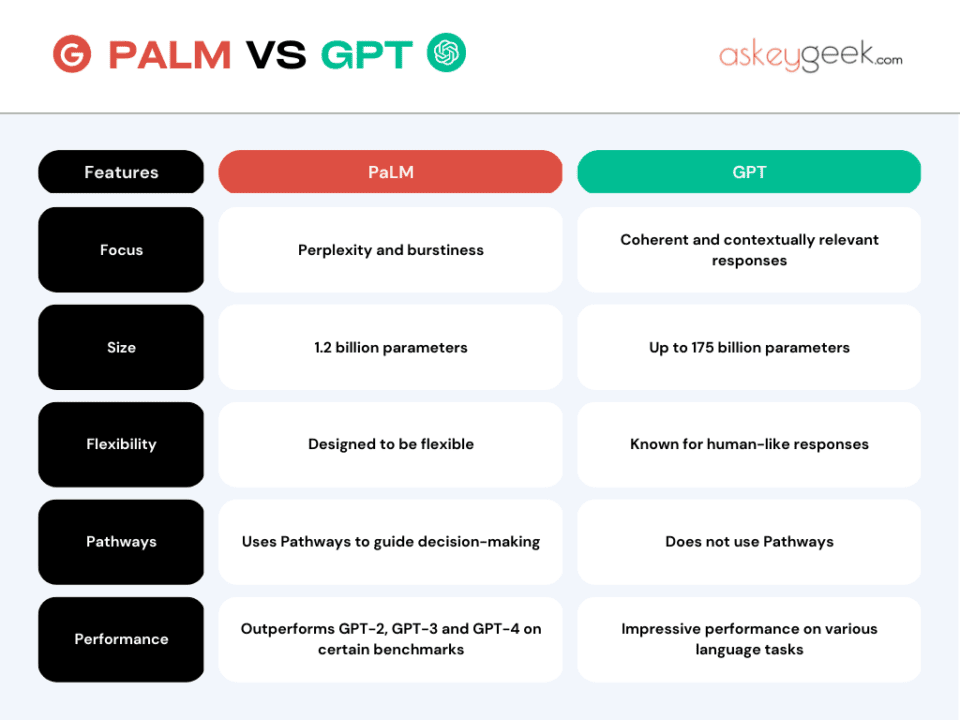

PaLM frente a GPT

Tanto PaLM como GPT son modelos impresionantes que demuestran el poder del modelado del lenguaje y su potencial para diversas aplicaciones. Sin embargo, también tienen algunas diferencias y compensaciones que exploraremos a continuación en la tabla comparativa de características de PaLM y GPT.

Características clave de PaLM

- Perplejidad y estallido

- 1,2 mil millones de parámetros

- Diseñado para ser flexible

- Utiliza Pathways para guiar la toma de decisiones

- Supera a GPT-2 y GPT-3 en ciertos puntos de referencia

Características clave de GPT

- Respuestas coherentes y contextualmente relevantes.

- Hasta 175 mil millones de parámetros

- Conocido por sus respuestas similares a las humanas.

- No utiliza caminos

- Rendimiento impresionante en diversas tareas lingüísticas.

Escalabilidad de PaLM y GPT

PaLM tiene una cantidad menor de parámetros que GPT-4, pero utiliza una estrategia de paralelismo más eficiente y una reformulación del bloque Transformer que permite un entrenamiento e inferencia más rápidos. PaLM logró una utilización de FLOP de hardware de 57,8%, la más alta alcanzada hasta ahora para LLM a esta escala.

GPT-4, por otro lado, utiliza más datos y recursos informáticos para entrenar su modelo más grande, lo que puede limitar su escalabilidad y accesibilidad.

Versatilidad de PaLM y GPT

Tanto PaLM como GPT-4 pueden generar texto en múltiples idiomas y dominios, pero PaLM tiene una ventaja en versatilidad debido a su sistema Pathways. PaLM puede aprovechar sus conocimientos y habilidades existentes para aprender nuevas tareas de forma rápida y eficaz aprovechando y combinando sus vías de acceso. Por ejemplo, PaLM puede generar código a partir de descripciones o imágenes en lenguaje natural sin ningún ajuste.

GPT-4, por otro lado, requiere más ajustes para tareas o dominios específicos, lo que puede reducir su capacidad de generalización y aumentar su dependencia de datos.

Rendimiento de PaLM y GPT

Tanto PaLM como GPT-4 logran un rendimiento de vanguardia en cientos de tareas de generación y comprensión de idiomas en diferentes dominios. Sin embargo, PaLM supera a GPT-4 en la mayoría de las tareas por márgenes significativos en muchos casos.

Por ejemplo, PaLM logra una mayor precisión que GPT-4 en inferencia de lenguaje natural (NLI), respuesta a preguntas (QA), resumen (SUM), análisis de sentimientos (SA), traducción automática (MT), subtítulos de imágenes (IC) y generación de código. (CG) y tareas de finalización de código (CC). Además, PaLM desbloquea nuevas capacidades que GPT-4 no tiene, como generar textos coherentes de formato largo o resultados multimodales.

Infografía PaLM vs GPT

Aquí hay una tabla que resume las diferencias entre PaLM y GPT:

Pin

Pin