Guía definitiva de modelos lingüísticos populares de gran tamaño

Imagínese que se esfuerza por escribir la historia perfecta, sus dedos se ciernen sobre el teclado mientras la página en blanco se burla de usted. De repente, recuerdas tu arma secreta: un gran modelo lingüístico (LLM). Con unas pocas indicaciones, el LLM teje una historia tan cautivadora que parece magia. Éste es sólo un ejemplo del poder de los LLM, sofisticados sistemas de inteligencia artificial que están cambiando nuestra forma de interactuar con la tecnología.

En el siempre cambiante e intrigante mundo de la Inteligencia Artificial (IA), los grandes modelos lingüísticos (LLM) han causado sensación por su impresionante capacidad para manejar el lenguaje humano. Pero, ¿qué son exactamente estos LLM y cómo revolucionan nuestras interacciones y tareas cotidianas? Adentrémonos en este cautivador mundo y descubramos algunos de los LLM más destacados que están dando forma al futuro de la IA.

Comprender los grandes modelos lingüísticos

Los LLM son modelos avanzados de aprendizaje automático que predicen y generan textos similares a los humanos. Pueden autocompletar frases, traducir idiomas e incluso redactar artículos enteros. Estos modelos han evolucionado desde simples predictores de palabras hasta complejos sistemas capaces de manejar párrafos y documentos.

¿Cómo funcionan los grandes modelos lingüísticos?

Los LLM estiman la probabilidad de secuencias de palabras, utilizando vastos conjuntos de datos para aprender patrones lingüísticos. Se basan en arquitecturas como Transformers, que se centran en las partes más relevantes de la entrada para procesar secuencias más largas de forma eficiente.

La evolución de los LLM: Del BERT al GPT-4

Ejemplos de grandes modelos lingüísticos en acción

ChatGPT, una variante de los modelos GPT de OpenAI, se ha convertido en un nombre muy conocido, impulsando chatbots que ofrecen interacciones similares a las humanas.

Impacto del BERT en las tareas de procesamiento del lenguaje natural

El BERT ha mejorado notablemente el rendimiento de las tareas de procesamiento del lenguaje natural, como el análisis de sentimientos y la traducción de idiomas.

GPT-3 y la frontera de la generación de textos

La capacidad de GPT-3 para generar textos creativos y coherentes ha abierto nuevas posibilidades en la creación de contenidos y más allá.

Comparación de los principales modelos lingüísticos actuales

Para comprender mejor la magnitud y diversidad de los grandes modelos lingüísticos, echemos un vistazo más de cerca a algunos de los modelos más influyentes disponibles públicamente que dominan actualmente el panorama. Cada modelo aporta ventajas únicas y destaca en distintos casos de uso.

Esta tabla ofrece una rápida visión general de algunos de los grandes modelos lingüísticos más influyentes en 2024. BERT, introducido por Google, es conocido por su arquitectura basada en transformadores y supuso un avance significativo en las tareas de procesamiento del lenguaje natural. Claudedesarrollado por Anthropic, se centra en la IA constitucional, con el objetivo de que los resultados de la IA sean útiles, inofensivos y precisos. Cohereofrece formación personalizada y ajustes para casos de uso específicos de la empresa. Ernie, de Baidu, tiene la asombrosa cifra de 10 billones de parámetros y está diseñado para sobresalir en mandarín, pero también es capaz en otros idiomas.

LLM locales frente a LLM en la nube

Aunque los LLM basados en la nube ofrecen capacidades impresionantes, una tendencia creciente es el uso de la inferencia local con modelos de código abierto. Herramientas como LM Studio permiten a los usuarios ejecutar ejecutar los LLM localmente directamente en sus máquinas.

Este enfoque da prioridad a la privacidad al mantener todos los datos y el procesamiento fuera de línea. Sin embargo, la inferencia local suele requerir un hardware más potente y puede limitar el acceso a los modelos más punteros debido a su tamaño.

Los 15 modelos más populares

| Nombre del modelo | Tamaño (Parámetros) | ¿Fuente abierta? | Última actualización (estimada) | Empresa | País de desarrollo |

| AI21 Studios Jurassic-1 Jumbo | 178B | Sí | Diciembre de 2022 | Estudios AI21 | Israel |

| Google Gemma | 2B o 7B | Sí | Mayo de 2023 | Google AI | Estados Unidos |

| Meta LLaMA 13B | 13B | Sí | Principios de 2023 | Meta IA | Estados Unidos |

| Meta LLaMA 7B | 7B | Sí | Principios de 2023 | Meta IA | Estados Unidos |

| EleutherAI GPT-J | 6B | Sí | Mayo de 2023 (a través de horquillas como Dolly 2) | EleutherAI (grupo de investigación) | Estados Unidos |

| La pila - EleutherAI | 900 GB de datos de texto | Sí | Desarrollo continuo | EleutherAI (grupo de investigación) | Estados Unidos |

| Mistral AI - Mistral Grande | No divulgado públicamente (Grande) | Código abierto con opciones de pago | Septiembre de 2023 | Mistral AI | Francia |

| Falcon 180B | 180B | Sí | No especificado | Instituto de Innovación Tecnológica | EAU |

| BERT | 342 millones de euros | No | Julio de 2018 | Google AI | Estados Unidos |

| Ernie | 10 billones | No | Agosto de 2023 | Baidu | China |

| OpenAI GPT-3.5 | 175B | No | Finales de 2022 | OpenAI | Estados Unidos |

| Claude | No especificado | No | No especificado | Antrópico | Estados Unidos |

| Cohere | No divulgado públicamente (Masivo) | No | Desarrollo continuo | Cohere | Canadá |

| Google PaLM (enfoque de investigación) | No revelado públicamente (Probablemente muy grande) | No | En desarrollo | Google AI | Estados Unidos |

| OpenAI GPT-4 | No divulgado públicamente (Sucesor de GPT-3.5) | No | En desarrollo | OpenAI | Estados Unidos |

Comparación de los LLM por país de desarrollo

Al comparar los 15 principales modelos de grandes lenguajes (LLM), Estados Unidos aporta casi 67% de la cuota de mercado de desarrollo de LLM por 10 de los 15.

| País de desarrollo | Número de modelos |

| Canadá | 1 |

| China | 1 |

| Francia | 1 |

| Israel | 1 |

| EAU | 1 |

| Estados Unidos | 10 |

| Total general | 15 |

Arquitecturas LLM y métodos de formación

| Arquitectura/Método | Descripción |

|---|---|

| Transformador | Una arquitectura de red neuronal que se basa en mecanismos de atención para mejorar la eficacia y precisión del procesamiento de datos secuenciales. Es la base de muchos LLM modernos. |

| Formación previa | La fase inicial del entrenamiento de un LLM consiste en exponerlo a una gran cantidad de datos de texto sin etiquetar para que aprenda los patrones estadísticos y las estructuras del lenguaje. |

| Puesta a punto | Perfeccionar un modelo preentrenado entrenándolo con datos específicos relacionados con una tarea concreta, mejorando su rendimiento para esa tarea. |

| QLoRA | Método que consiste en propagar gradientes hacia atrás a través de un modelo lingüístico congelado, cuantificado en 4 bits y preentrenado en adaptadores de bajo rango (LoRA), lo que permite un ajuste fino eficaz. |

La arquitectura de transformadores ha revolucionado el campo del procesamiento del lenguaje natural al permitir que los modelos manejen secuencias largas de datos con mayor eficacia. El preentrenamiento y el ajuste fino son etapas críticas en el desarrollo de los LLM, ya que les permiten aprender de grandes cantidades de datos y luego especializarse en tareas específicas. QLoRA representa una técnica avanzada para afinar los LLM, reduciendo la demanda de memoria y manteniendo el rendimiento.

Principales casos de uso de los grandes modelos lingüísticos

Cómo los LLM revolucionan la traducción de idiomas y el análisis de sentimientos

Los LLM han transformado la traducción de idiomas al comprender y traducir enormes cantidades de datos, mientras que el análisis de sentimientos se ha matizado gracias a sus capacidades de aprendizaje profundo.

Mejora de las interacciones hombre-máquina con chatbots

Los chatbots impulsados por LLM ofrecen una atención al cliente personalizada y eficiente, cambiando la cara de la atención al cliente.

Transformar la creación de contenidos mediante la IA generativa

Los modelos de IA generativa como GPT-3 han hecho posible la creación rápida de contenidos de alta calidad, ayudando tanto a escritores como a diseñadores.

Retos y limitaciones de la implantación de los LLM

Preocupación por la parcialidad y el uso ético

Los datos de entrenamiento de los LLM pueden introducir sesgos, lo que plantea problemas éticos que deben abordarse.

Entender los costes computacionales del entrenamiento de grandes modelos

El entrenamiento de los LLM requiere importantes recursos computacionales, lo que puede resultar costoso e insostenible desde el punto de vista medioambiental.

Las limitaciones de la comprensión lingüística y la comprensión del contexto

A pesar de sus capacidades, los LLM siguen teniendo dificultades para comprender el contexto y las sutilezas del lenguaje humano.

Cómo se entrenan y afinan los grandes modelos lingüísticos

La importancia de una gran cantidad de datos en la formación previa a los LLM

Los LLM necesitan grandes conjuntos de datos para aprender una amplia gama de patrones y matices lingüísticos.

Técnicas de ajuste para aplicaciones específicas

Se utilizan técnicas como el aprendizaje por transferencia y el ajuste fino con modelos transformadores para adaptar los LLM a tareas específicas.

Surgimiento de modelos básicos en el aprendizaje automático

Los modelos de base son una nueva tendencia en el aprendizaje automático, ya que proporcionan una base para construir modelos especializados.

Diferencias entre el preentrenamiento y el entrenamiento específico de la tarea

El preentrenamiento y el entrenamiento específico de tareas (a menudo denominado ajuste fino) son dos fases críticas en el desarrollo de grandes modelos lingüísticos (LLM). Estas fases son fundamentales para que los LLM comprendan y generen textos similares a los humanos, y cada una de ellas tiene un propósito distinto en el proceso de aprendizaje del modelo.

Pre-formación LLM

El preentrenamiento es la fase inicial y exhaustiva en la que un LLM aprende a partir de un amplio corpus de datos de texto. Esta fase equivale a proporcionar al modelo una amplia educación sobre lengua, cultura y conocimientos generales. Estos son los aspectos clave del preentrenamiento:

- Base general de conocimientos: El modelo desarrolla una comprensión de la gramática, las expresiones idiomáticas, los hechos y el contexto mediante el análisis de un amplio corpus de textos. Esta amplia base de conocimientos permite al modelo generar respuestas coherentes y adecuadas al contexto.

- Aprendizaje por transferencia: Los modelos preentrenados pueden aplicar sus patrones lingüísticos aprendidos a nuevos conjuntos de datos, lo que resulta especialmente útil para tareas con datos limitados. Esta capacidad reduce significativamente la necesidad de disponer de una gran cantidad de datos específicos de la tarea.

- Relación coste-eficacia: A pesar de los considerables recursos informáticos necesarios para el preentrenamiento, el mismo modelo puede reutilizarse en varias aplicaciones, lo que lo convierte en un enfoque rentable.

- Flexibilidad y escalabilidad: El amplio conocimiento obtenido durante el preentrenamiento permite adaptar el mismo modelo a diversas tareas. Además, a medida que se dispone de nuevos datos, los modelos preentrenados pueden seguir entrenándose para mejorar su rendimiento.

Formación específica para cada tarea (perfeccionamiento)

Tras el preentrenamiento, los modelos se someten a una fase de perfeccionamiento en la que se entrenan con conjuntos de datos más pequeños y específicos para cada tarea. Esta fase adapta los amplios conocimientos del modelo para que funcione bien en tareas concretas. Los aspectos clave del ajuste fino son:

- Especialización de tareas: El ajuste fino adapta los modelos preentrenados a tareas o sectores específicos, mejorando su rendimiento en aplicaciones concretas.

- Eficacia y velocidad de los datos: Dado que el modelo ya ha aprendido patrones lingüísticos generales durante el preentrenamiento, el ajuste fino requiere menos datos y tiempo para especializar el modelo para tareas específicas.

- Personalización de modelos: El ajuste fino permite personalizar el modelo para adaptarlo a los requisitos únicos de las distintas tareas, lo que lo hace muy adaptable a aplicaciones especializadas.

- Eficiencia de los recursos: El ajuste fino es especialmente beneficioso para aplicaciones con recursos computacionales limitados, ya que aprovecha el trabajo pesado realizado durante el preentrenamiento.

En resumen, el preentrenamiento dota a los LLM de una amplia comprensión del lenguaje y de conocimientos generales, mientras que el ajuste fino adapta estos conocimientos para que destaquen en tareas específicas. El preentrenamiento sienta las bases de las capacidades lingüísticas del modelo, y el ajuste fino optimiza estas capacidades para aplicaciones específicas, equilibrando la generalización y la especialización del modelo.

El futuro de los grandes modelos lingüísticos

Anticipando los LLM de próxima generación: GPT-4 y más allá

La próxima generación de LLMs, como GPT-4, se espera que amplíe aún más los límites de lo que es posible en la IA.

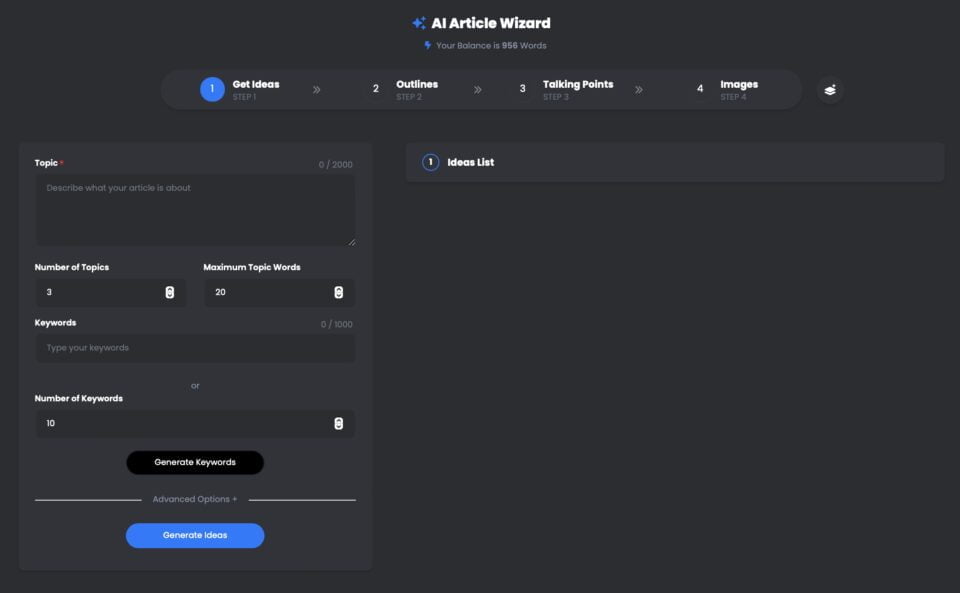

Asistente de artículos UberCreate AI es una potente herramienta que aprovecha el gran modelo lingüístico (LLM) GPT-4 de OpenAI para generar artículos de alta calidad en cuestión de minutos.

Con UberCreate, puede decir adiós al bloqueo del escritor y hola a un artículo detallado en cuestión de minutos. Sólo tiene que proporcionar un tema, una palabra clave y un recuento de palabras objetivo, y UberCreate se encargará del resto. Generará un esquema del artículo, temas de conversación, imágenes relevantes y un artículo final listo para publicar.

Asistente de creación de artículos UberCreate AI con GPT-4

Pin

Pin UberCreate utiliza tecnología avanzada de inteligencia artificial para crear contenidos originales, atractivos e informativos. Puede escribir sobre cualquier tema, desde negocios y marketing hasta salud y estilo de vida. También puede adaptarse a diferentes tonos, estilos y formatos, en función de tus preferencias y necesidades.

UberCreate no es sólo un generador de contenidos, sino también un mejorador de contenidos. Puede ayudarte a mejorar tus artículos añadiendo más detalles, datos e imágenes. También puede comprobar tu gramática, ortografía y legibilidad, y sugerirte formas de optimizar tu contenido para SEO y redes sociales.

UberCreate es la única herramienta de creación de contenidos de IA que necesitarás. Combina 17 herramientas de IA en una, incluyendo un generador de entradas de blog, un generador de contenidos para redes sociales, un generador de contenidos visuales y mucho más. Está diseñada para facilitar todos los aspectos de la creación de contenidos, desde la ideación hasta la producción.

Si usted es un blogger, un vendedor, un estudiante o un profesional, UberCreate puede ayudarle a ahorrar tiempo, dinero y esfuerzo en la creación de contenidos de alta calidad. Puedes probarlo gratis y ver los resultados por ti mismo.

Ampliación de los límites de la colaboración entre el ser humano y la inteligencia artificial

LLMs van a mejorar la colaboración entre los seres humanos y la IA, haciendo que las interacciones sean más naturales y productivas.

Estos destacados LLM son solo la punta del iceberg cuando se trata de comprender el enorme potencial de los grandes modelos lingüísticos para revolucionar nuestras interacciones con la tecnología y ampliar los límites de la colaboración entre humanos e IA. Permanezca atento a la segunda parte de esta serie, en la que profundizaremos en las capacidades de los grandes modelos lingüísticos, sus aplicaciones en diversos sectores y los retos que conlleva aprovechar su potencia.

Perspectivas de la comprensión del lenguaje natural en la próxima década

El futuro parece prometedor para la comprensión del lenguaje natural, ya que los LLM son cada vez más sofisticados y se integran en diversas aplicaciones.

En conclusiónLLM como el BERT, el GPT-3 y sus sucesores están revolucionando sectores como la educación o la sanidad. A medida que seguimos aprovechando su poder, también debemos afrontar los retos que plantean, garantizando su uso ético y responsable. El viaje al mundo de los grandes modelos lingüísticos no ha hecho más que empezar, y las posibilidades son tan amplias como los conjuntos de datos de los que aprenden. Sumérjase en este apasionante campo y demos forma juntos al futuro de la IA.

Preguntas frecuentes (FAQ)

¿Qué es un modelo lingüístico amplio (LLM) en el contexto de la PNL?

En el ámbito del Procesamiento del Lenguaje Natural (PLN), un modelo lingüístico amplio (LLM) es un sistema avanzado de inteligencia artificial diseñado para comprender, interpretar y generar texto similar al humano. Estos modelos se entrenan con grandes cantidades de datos, lo que les permite realizar una amplia gama de tareas lingüísticas. Mediante el proceso de entrenamiento, el modelo aprende a predecir la siguiente palabra de una frase, lo que le ayuda a generar texto coherente y contextualmente relevante a demanda.

¿Cuáles son los diferentes tipos de LLM disponibles en 2024?

A partir de 2024, existen varios tipos diferentes de Large Language Models, cada uno con capacidades únicas. Entre los más destacados se encuentran modelos como GPT-4, conocido por sus capacidades de generación de texto, y Bard, que es el homólogo de Google centrado en una amplia gama de tareas de PNL. Estos modelos difieren en el número de parámetros, los datos con los que se han entrenado y sus aplicaciones específicas, que van desde la simple generación de texto a tareas complejas de comprensión del lenguaje.

¿Cómo se entrenan los LLM en grandes conjuntos de datos?

Los LLM se entrenan utilizando vastos conjuntos de datos recogidos en Internet, como libros, artículos y páginas web. Este exhaustivo proceso de entrenamiento implica alimentar el modelo con grandes cantidades de datos de texto, lo que le ayuda a identificar patrones, comprender el contexto y aprender estructuras lingüísticas. El proceso de entrenamiento puede durar semanas o incluso meses, dependiendo del tamaño del modelo y de los recursos informáticos disponibles. El objetivo es que el modelo genere textos que no se distingan de los escritos por humanos.

¿Puede explicar las aplicaciones de los LLM en las tareas cotidianas?

Los LLM pueden utilizarse en diversas aplicaciones para simplificar y automatizar tareas cotidianas. Esto incluye chatbots y asistentes virtuales para atención al cliente, herramientas de creación de contenidos para generar artículos o informes, y servicios de traducción para convertir texto entre idiomas. Otras aplicaciones incluyen el análisis de sentimientos para medir la opinión pública en las redes sociales, herramientas de resumen para condensar documentos largos en versiones más breves, e incluso asistentes de codificación para ayudar a los programadores generando fragmentos de código. Esencialmente, los LLM han revolucionado nuestra forma de interactuar con la tecnología, haciéndola más intuitiva y humana.

¿En qué se diferencian las capacidades de los grandes modelos lingüísticos de las de los modelos tradicionales?

Los grandes modelos lingüísticos superan con creces a los modelos tradicionales en varios aspectos. En primer lugar, gracias a su amplia formación en diversos conjuntos de datos, los LLM pueden generar respuestas más coherentes, variadas y adecuadas al contexto. Comprenden mejor los matices del lenguaje y pueden manejar datos secuenciales con mayor eficacia. Además, el gran número de parámetros de los LLM permite razonamientos más sofisticados y capacidades predictivas en comparación con los modelos tradicionales, más limitados en cuanto a alcance y escalabilidad. En definitiva, los LLM ofrecen un enfoque más matizado y versátil para procesar y generar lenguaje.

¿Qué retos plantea el desarrollo y la implantación de los LLM?

El desarrollo y la implantación de los LLM plantean varios retos, como los recursos informáticos necesarios para el entrenamiento, que pueden ser considerables. Además, existe preocupación por la parcialidad de los datos de entrenamiento, que puede llevar al modelo a generar contenidos perjudiciales o con prejuicios. La sensibilidad de los datos utilizados en el entrenamiento también plantea problemas de privacidad. Además, la interpretabilidad de estos modelos plantea un reto, ya que su proceso de toma de decisiones es complejo y no siempre transparente. Por último, el impacto medioambiental del proceso de entrenamiento, que consume mucha energía, es una preocupación creciente.

¿Cómo influyen los modelos lingüísticos como GPT-4 y Bard en el campo de la PNL?

Modelos como GPT-4 y Bard han hecho avanzar significativamente el campo del Procesamiento del Lenguaje Natural al demostrar un rendimiento sin precedentes en una amplia gama de tareas de PLN. Su capacidad para generar texto, comprender el contexto y producir respuestas similares a las humanas ha establecido nuevos estándares para lo que la IA puede lograr en la comprensión y producción del lenguaje. Estos modelos no solo han mejorado la calidad y la eficiencia de aplicaciones como los chatbots, la generación de contenidos y la traducción de idiomas, sino que también han abierto nuevas vías de investigación y desarrollo en PLN, ampliando los límites de las capacidades de la IA.

¿Existe una guía para principiantes sobre cómo entender y trabajar con los LLM?

Sí, para los recién llegados a este campo, una guía para principiantes sobre los grandes modelos lingüísticos puede ser increíblemente útil. Una guía de este tipo suele cubrir los aspectos básicos de qué son los LLM, cómo se entrenan y sus aplicaciones. Puede ofrecer información sobre los modelos más significativos en 2023, explicar la tecnología subyacente y proporcionar ejemplos de tareas de PLN que pueden realizarse con LLM. Los principiantes pueden buscar recursos en línea, tutoriales y cursos que ofrezcan una introducción a estos conceptos, ayudando a construir una comprensión básica de cómo funcionan los LLM y cómo pueden utilizarse en diversos proyectos.